产品架构

产品规格

产品优势

应用场景

产品功能

客户案例

使用指南

产品动态

产品规格

选择规格

规格类型规格详情

容器服务-托管容器集群

弹性容器实例-通用型

弹性容器实例-GPU计算型

云服务器节点

GPU云服务器节点

弹性裸金属节点

云服务器节点

基于火山引擎通用型云服务器创建集群节点,能满足大部分通用业务的资源需求。

适用场景

通用Web应用

有状态后端服务

数据库类型服务

应用场景

.png)

产品功能

立即咨询

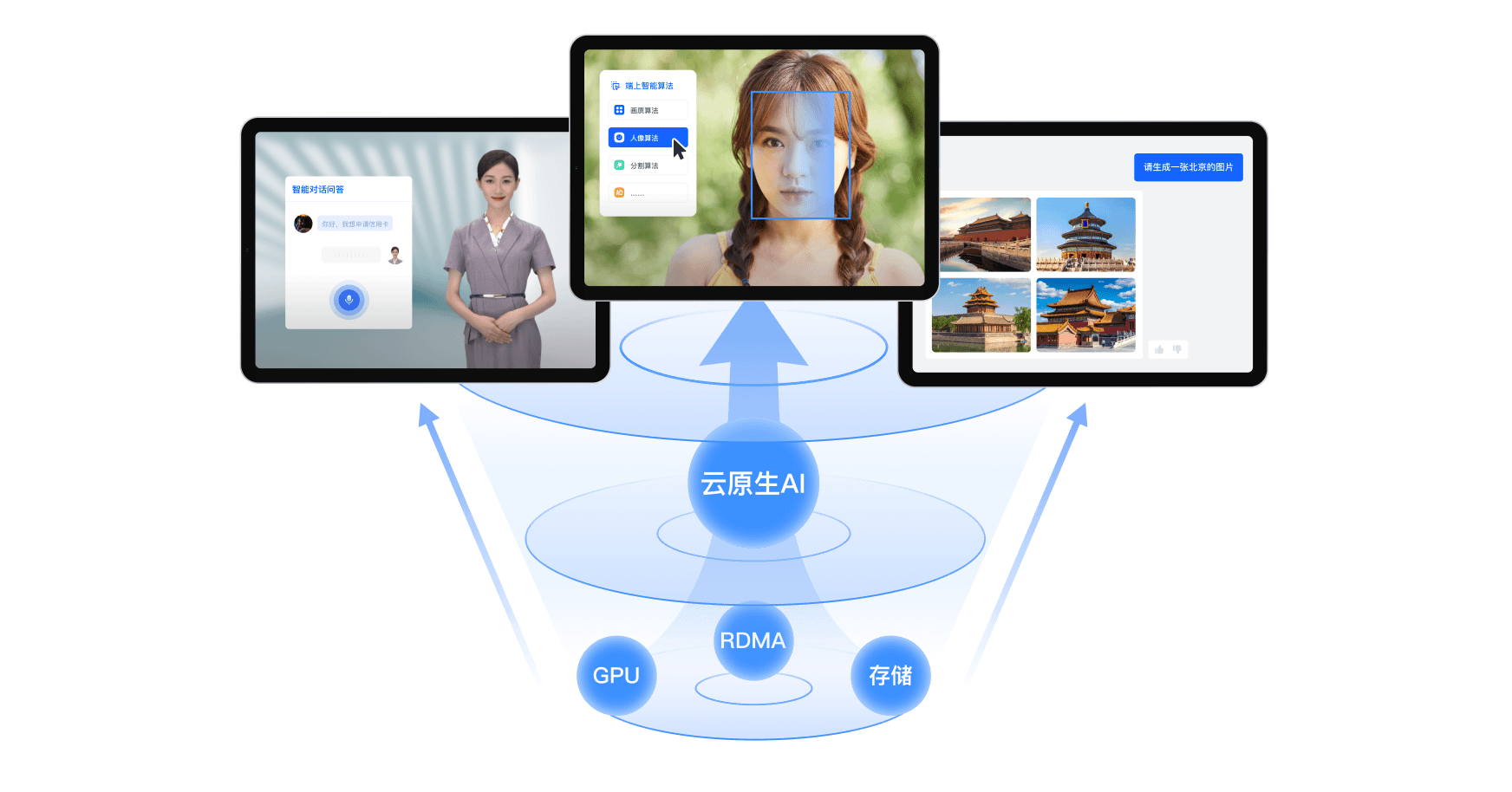

AI资源管理

支持GPU显存和算力的严格隔离,和算力细粒度分配,支持业务混部,实现GPU资源利用率的大幅提升。详情详情

AI负载弹性伸缩

丰富的弹性伸缩策略,支持自定义指标伸缩、事件驱动伸缩、智能伸缩等策略。详情详情

AI资源观测

支持GPU 、RDMA资源观测,提供丰富的指标,支持多粒度的展示,提升AI运维的效率。详情详情

AI数据加速

将数据从存储位置缓存到算力近端,缩短算力端加载模型用时,提升AI训练和大模型应用的推理运行速度。详情详情

集群管理

创建开箱即用的Kubernetes集群,控制面节点完全托管,可选网络模型,支持公网访问,可一键升级集群。详情详情

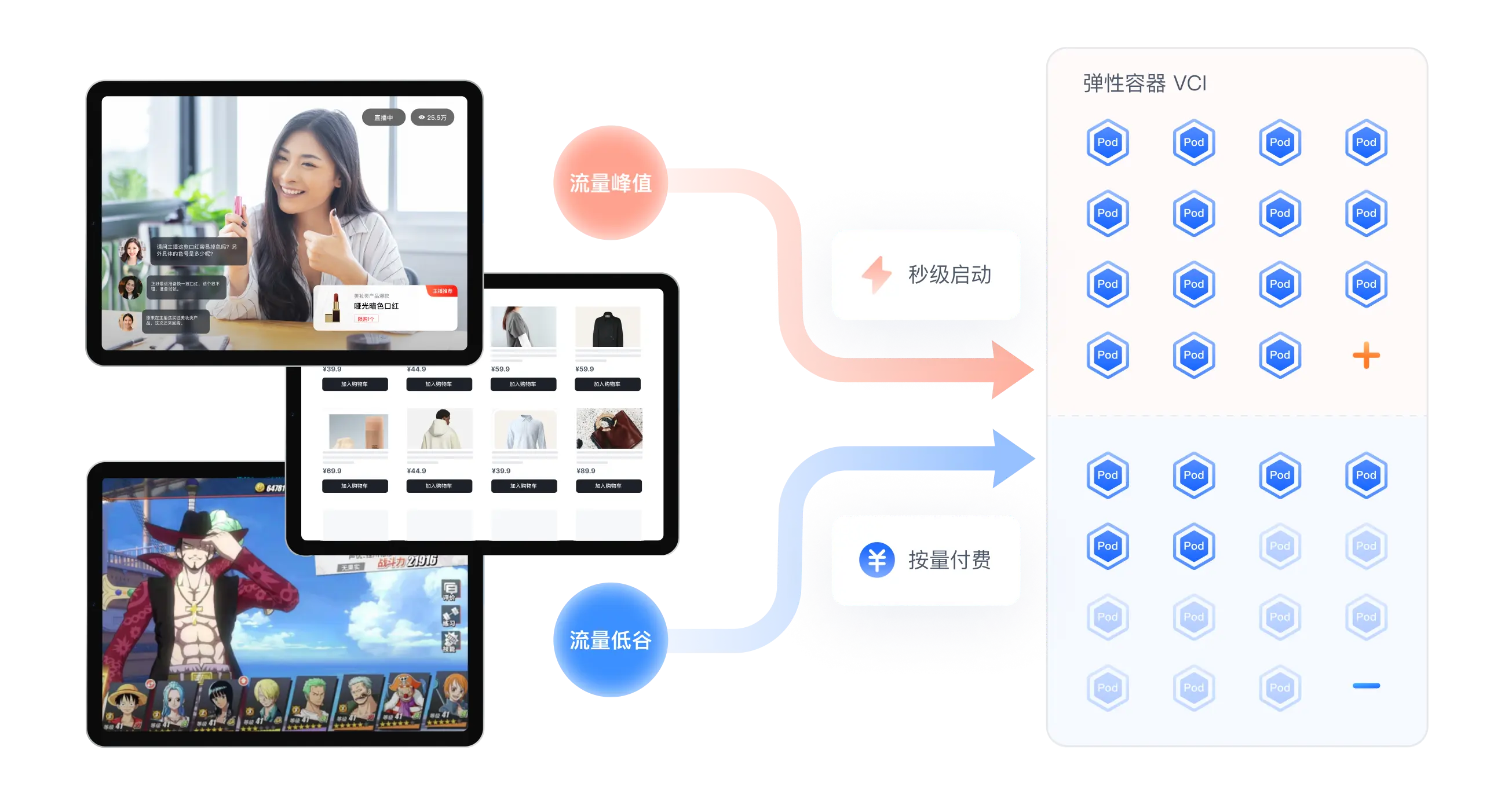

弹性容器

基于安全沙箱构建实例,提供虚拟机级别的隔离,无缝集成容器集群,支持秒级启动,具备灵活弹性伸缩能力。详情详情

调度管理

丰富的调度策略满足在离线等不同场景的业务需求,在保障应用性能的同时最大化提高资源利用率。详情详情

授权管理

支持面向云资源的IAM权限控制和面向容器服务的RBAC权限控制。提供丰富的预设策略并支持用户自定义。详情详情

AI资源管理

支持GPU显存和算力的严格隔离,和算力细粒度分配,支持业务混部,实现GPU资源利用率的大幅提升。详情详情

AI负载弹性伸缩

丰富的弹性伸缩策略,支持自定义指标伸缩、事件驱动伸缩、智能伸缩等策略。详情详情

AI资源观测

支持GPU 、RDMA资源观测,提供丰富的指标,支持多粒度的展示,提升AI运维的效率。详情详情

AI数据加速

将数据从存储位置缓存到算力近端,缩短算力端加载模型用时,提升AI训练和大模型应用的推理运行速度。详情详情

集群管理

创建开箱即用的Kubernetes集群,控制面节点完全托管,可选网络模型,支持公网访问,可一键升级集群。详情详情

弹性容器

基于安全沙箱构建实例,提供虚拟机级别的隔离,无缝集成容器集群,支持秒级启动,具备灵活弹性伸缩能力。详情详情

调度管理

丰富的调度策略满足在离线等不同场景的业务需求,在保障应用性能的同时最大化提高资源利用率。详情详情

授权管理

支持面向云资源的IAM权限控制和面向容器服务的RBAC权限控制。提供丰富的预设策略并支持用户自定义。详情详情

.webp)