本文档介绍数据流管理的主要功能与数据流配置的基本流程。

数据流管理模块支持客户在控制台创建数据流,以实现内容数据按照配置自动化写入指定数据库或消息队列。

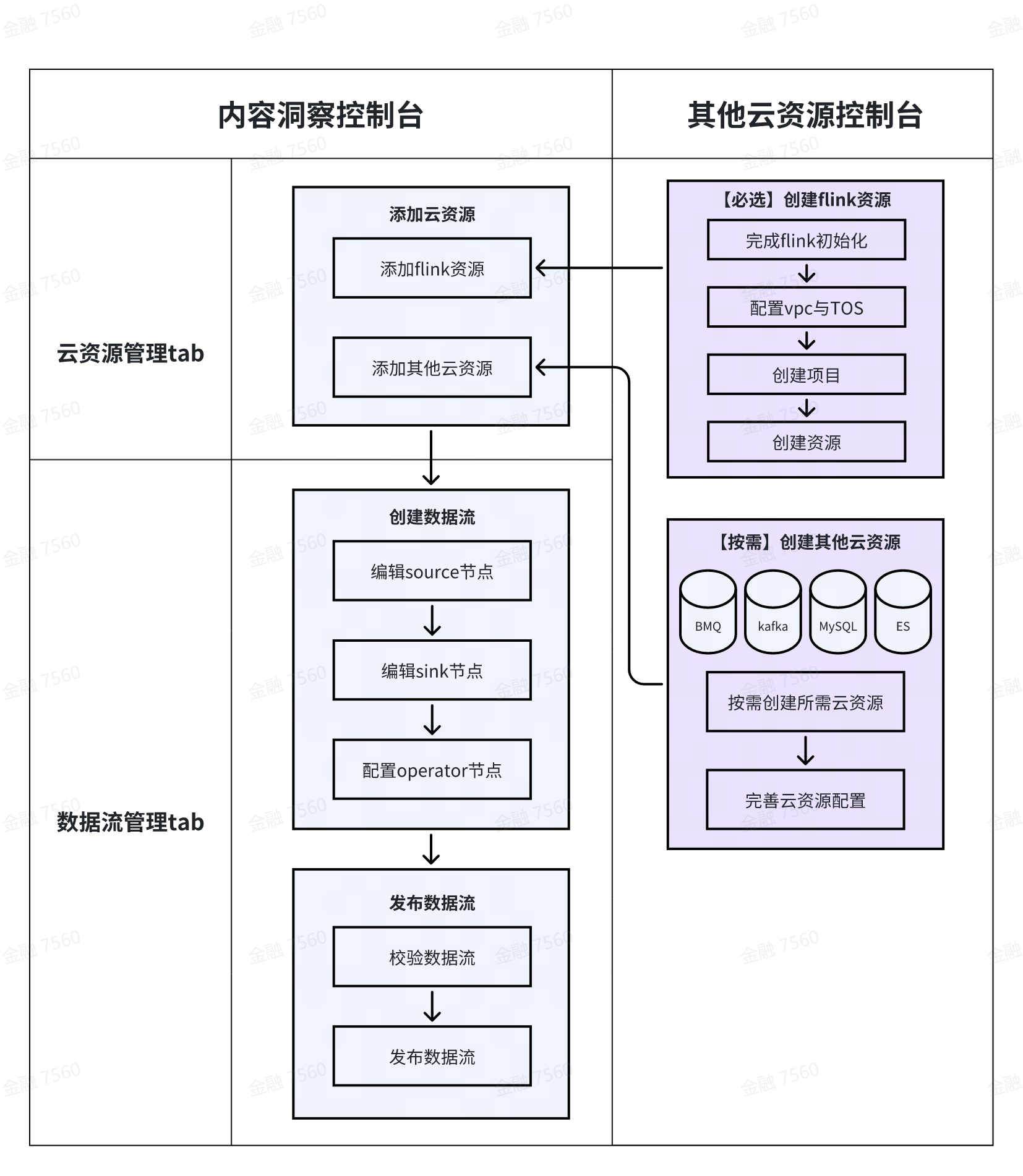

数据流配置流程分为如下几步:

创建云资源:请提前创建运行数据流所必需的flink资源,并按需下单其他云资源

添加云资源:在洞察控制台-云资源管理页添加数据流运行所用到的云资源

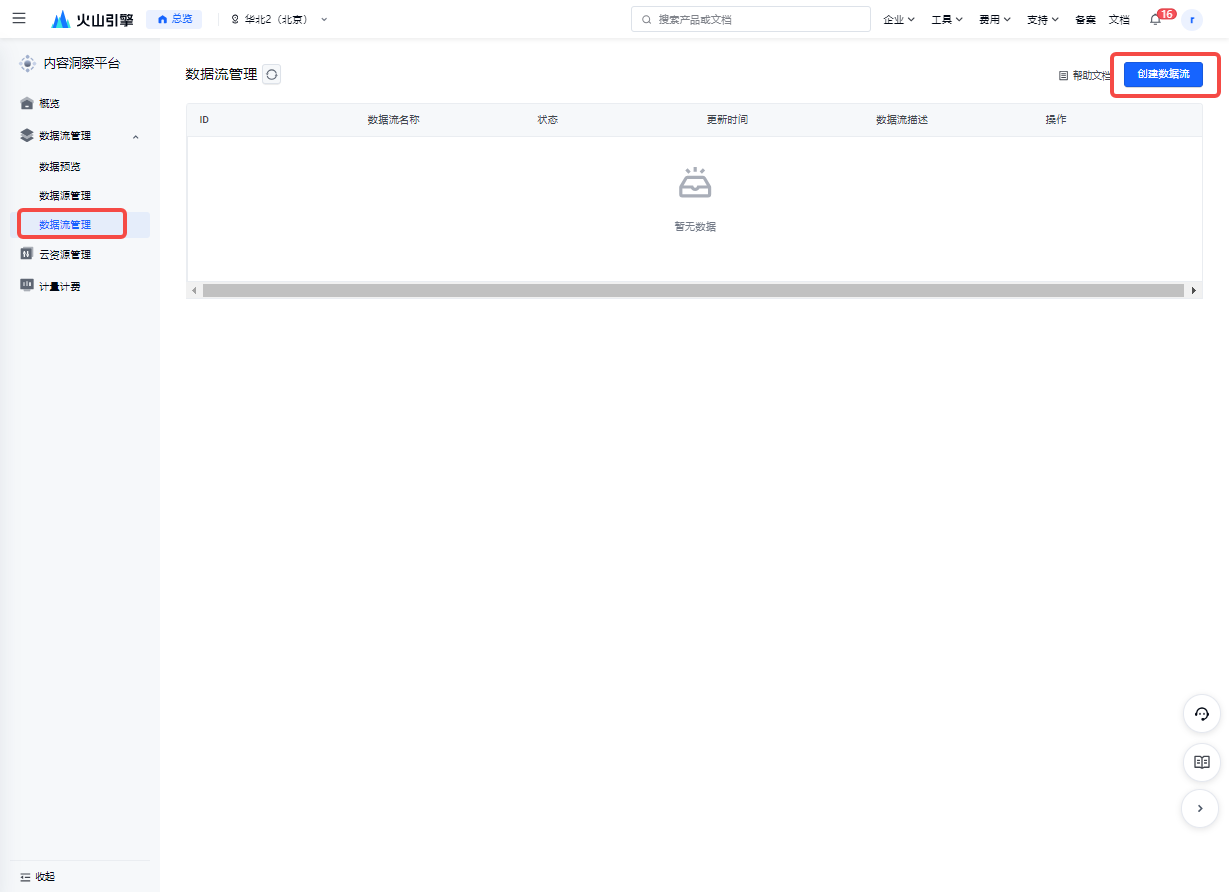

创建数据流:在洞察控制台-数据流管理页创建数据流,编辑节点信息

发布数据流:校验数据流,校验通过后发布上线

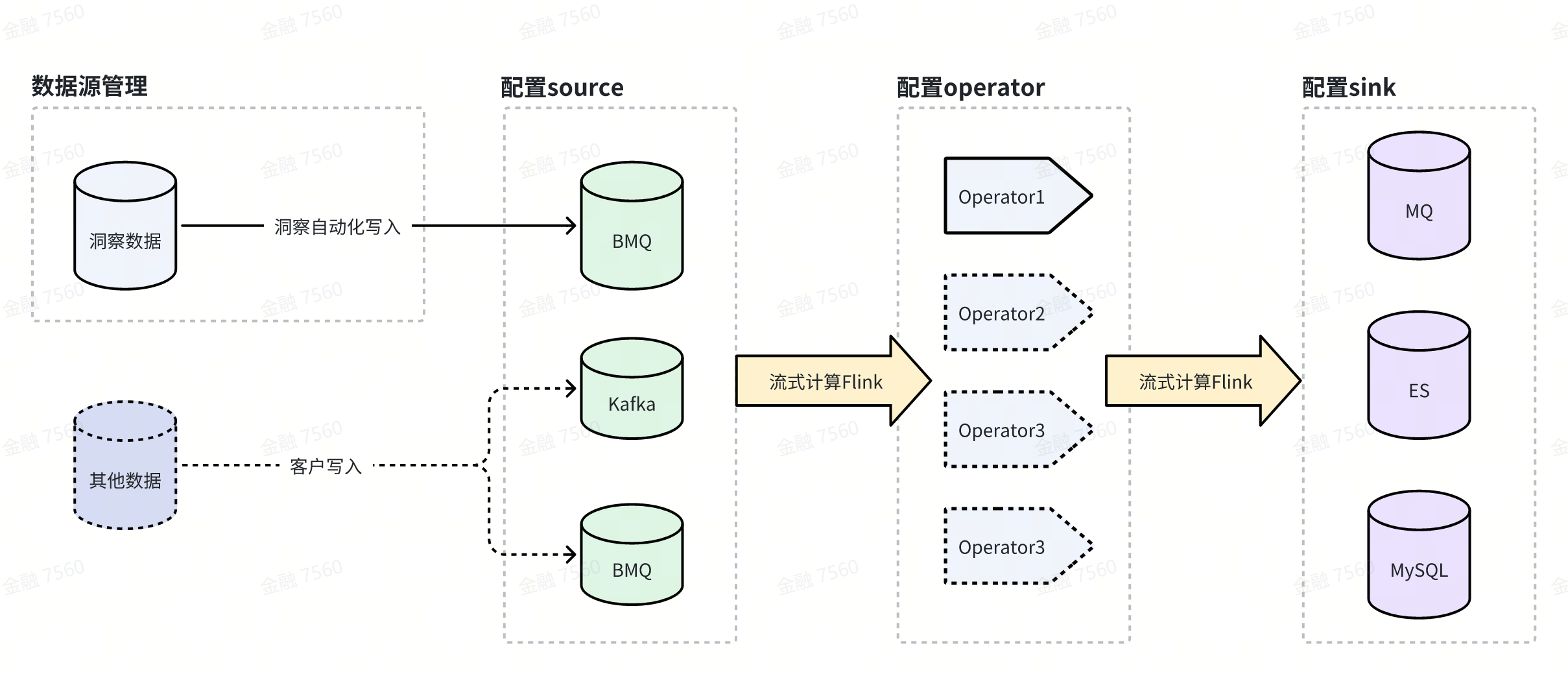

数据流配置流程图

数据流链路示意图

当前可支持配置的数据流链路如图所示

洞察支持客户在控制台配置数据流节点,实现各环节下不同云组件的自动化对接,以下详细介绍各节点功能。

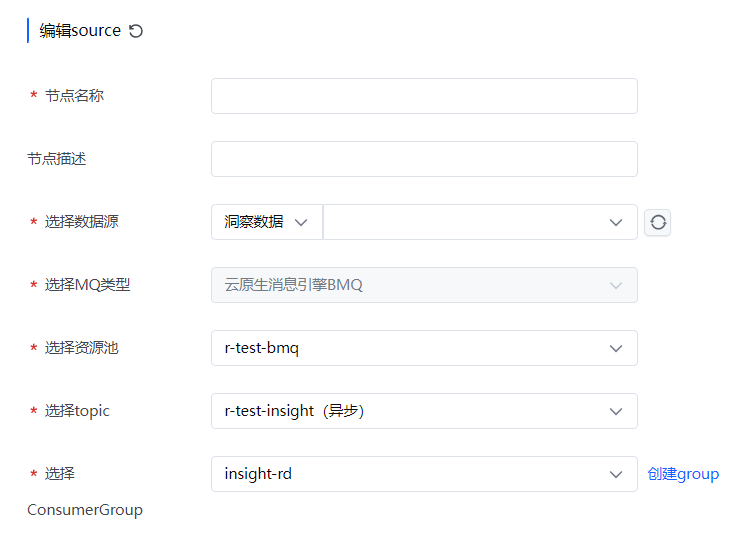

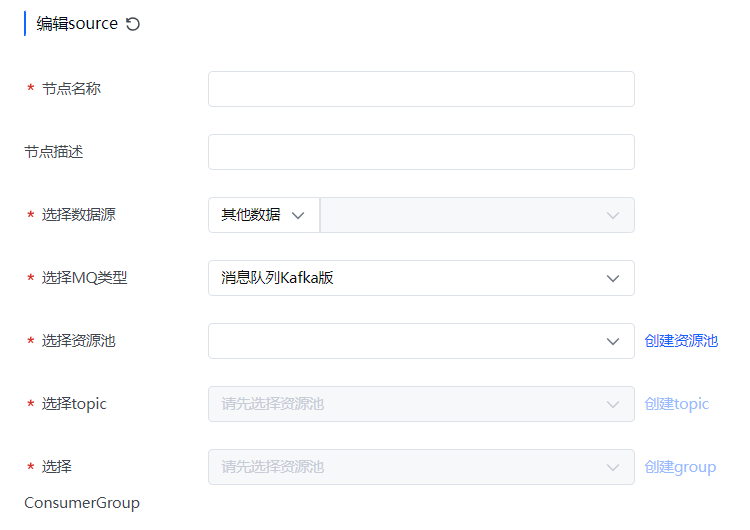

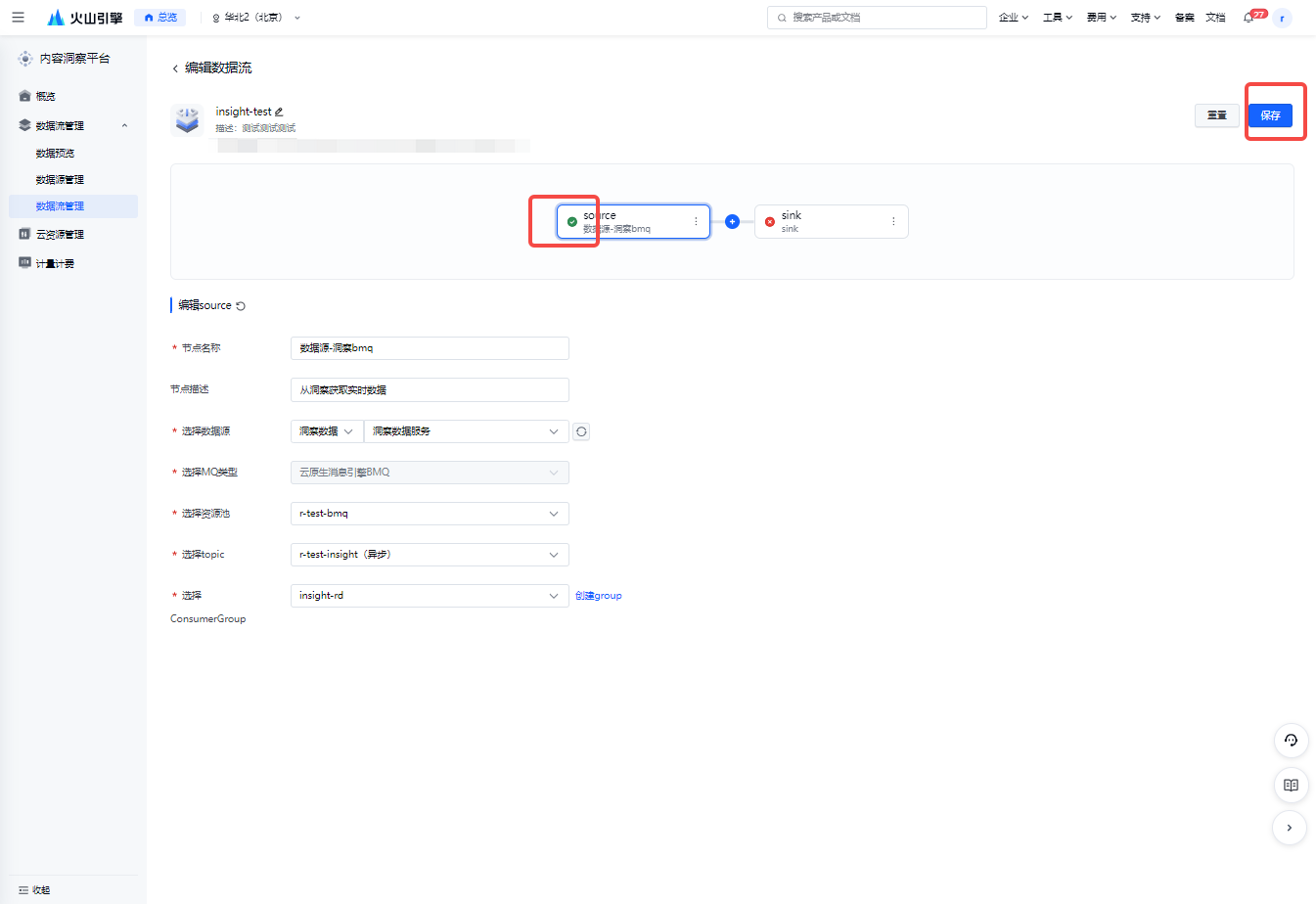

Source

Source指要处理的数据源(对应MQ某个topic),是数据流的起点。

目前洞察支持在source节点配置如下云组件:

| 支持组件 | 配置内容 | 详细说明 |

|---|---|---|

BMQ |

|

|

Kafka |

|

|

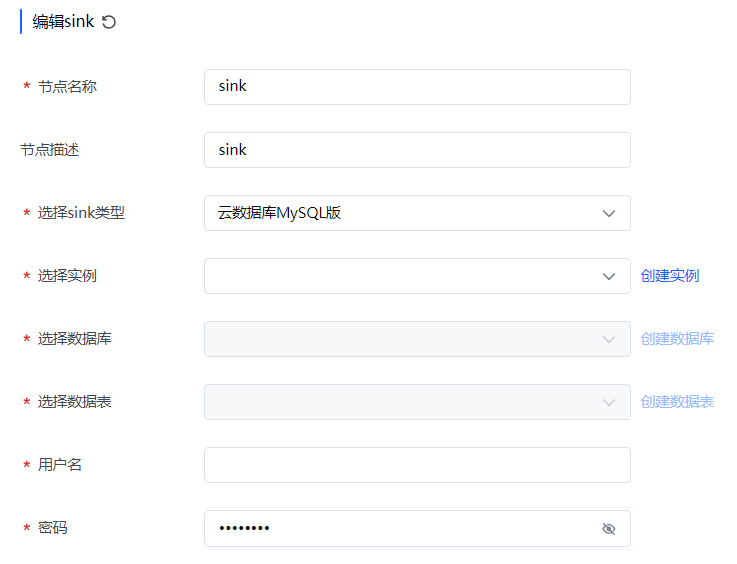

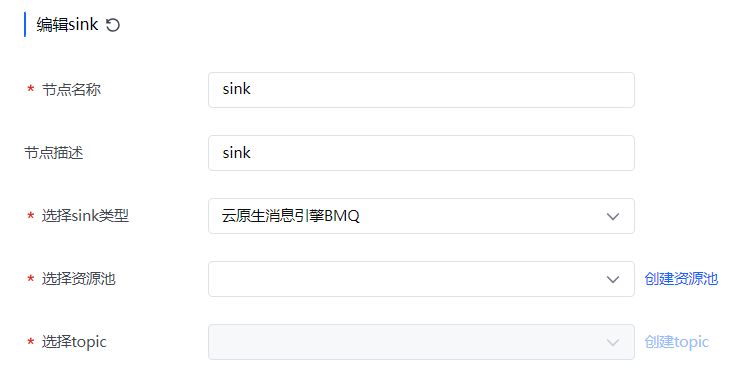

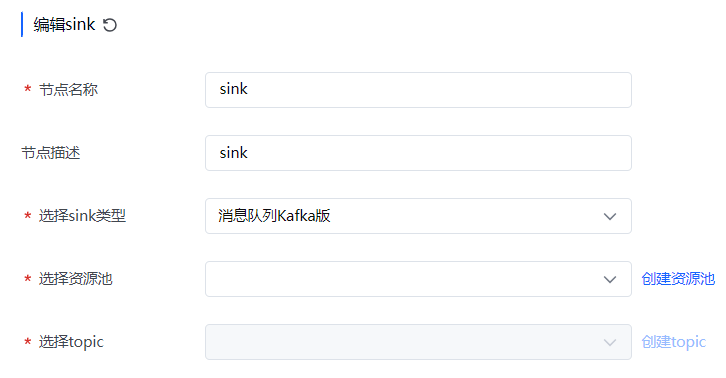

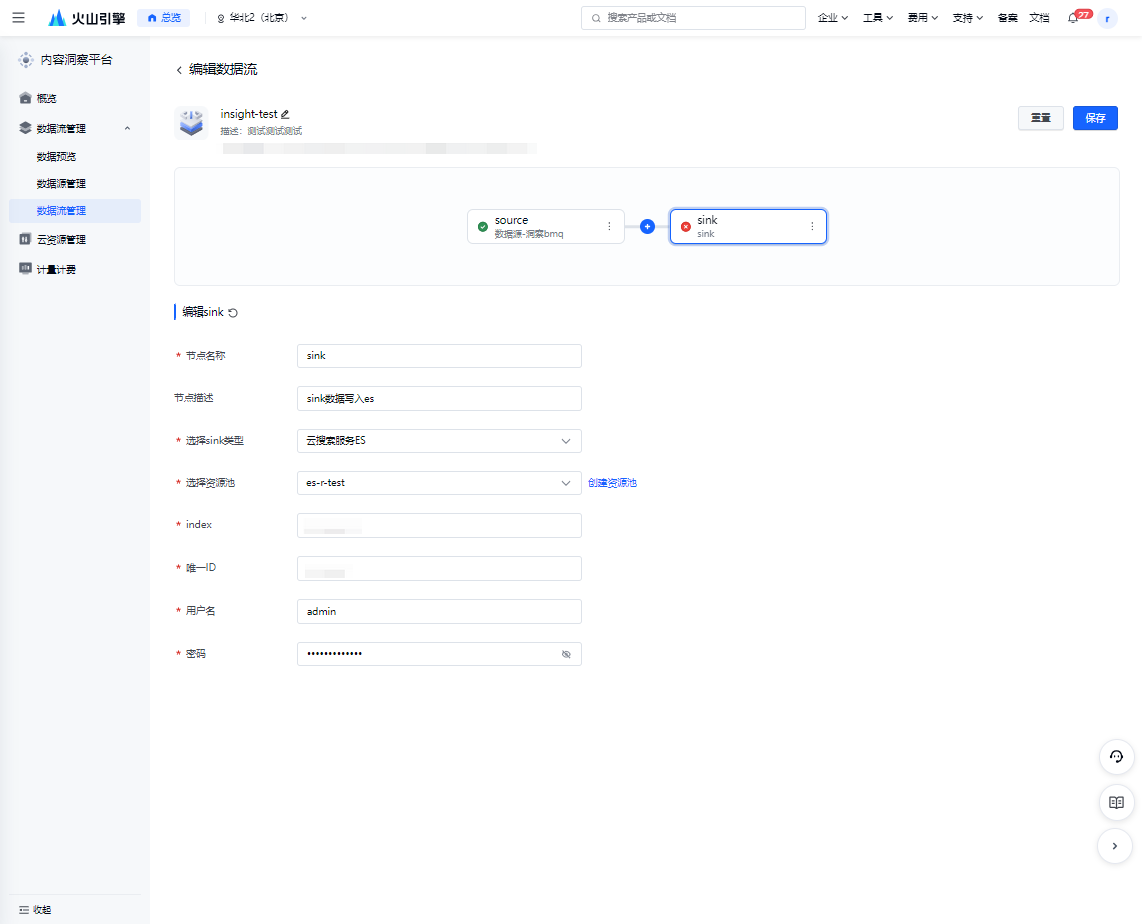

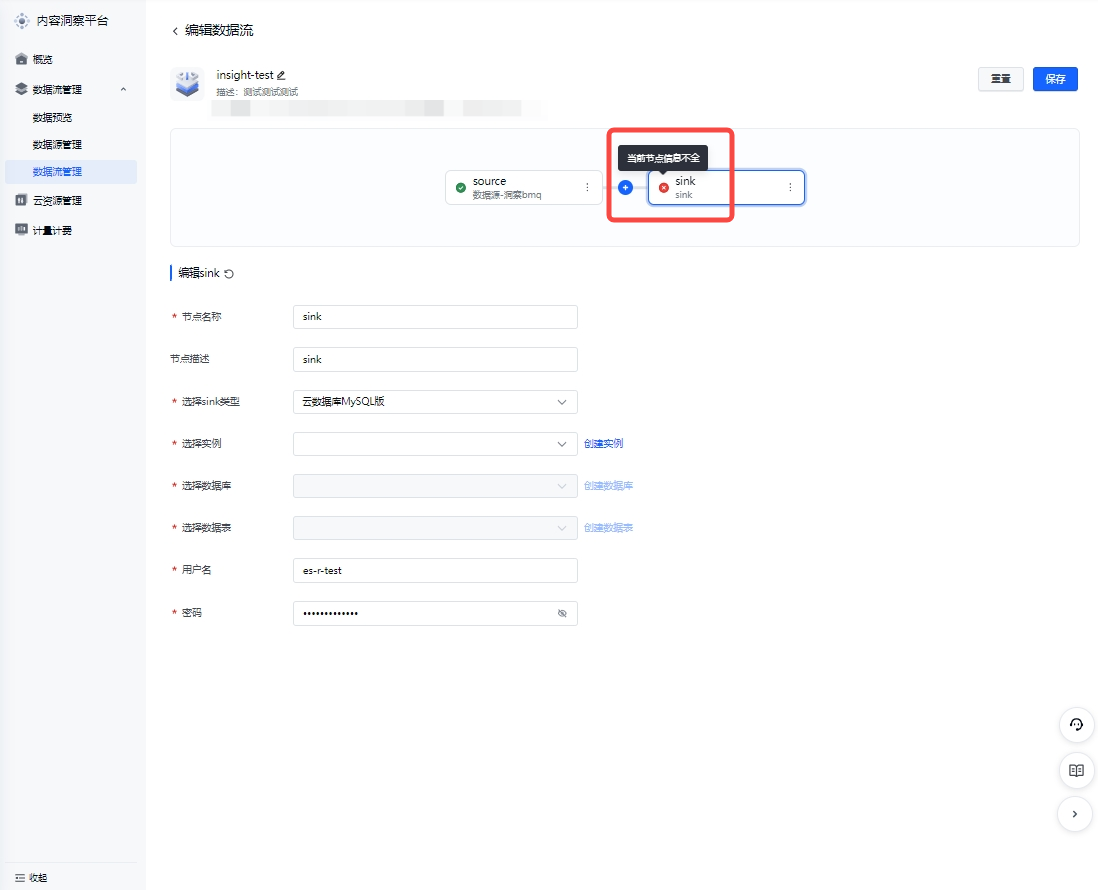

Sink

Sink指数据最终要写入的目标位置(例如MQ某个topic/数据表),是数据流的终点。

目前洞察支持在sink节点配置如下云组件:

| 支持组件 | 配置内容 | 详细说明 |

|---|---|---|

ES |

|

|

MySQL |

|

|

BMQ |

|

|

Kafka |

|

|

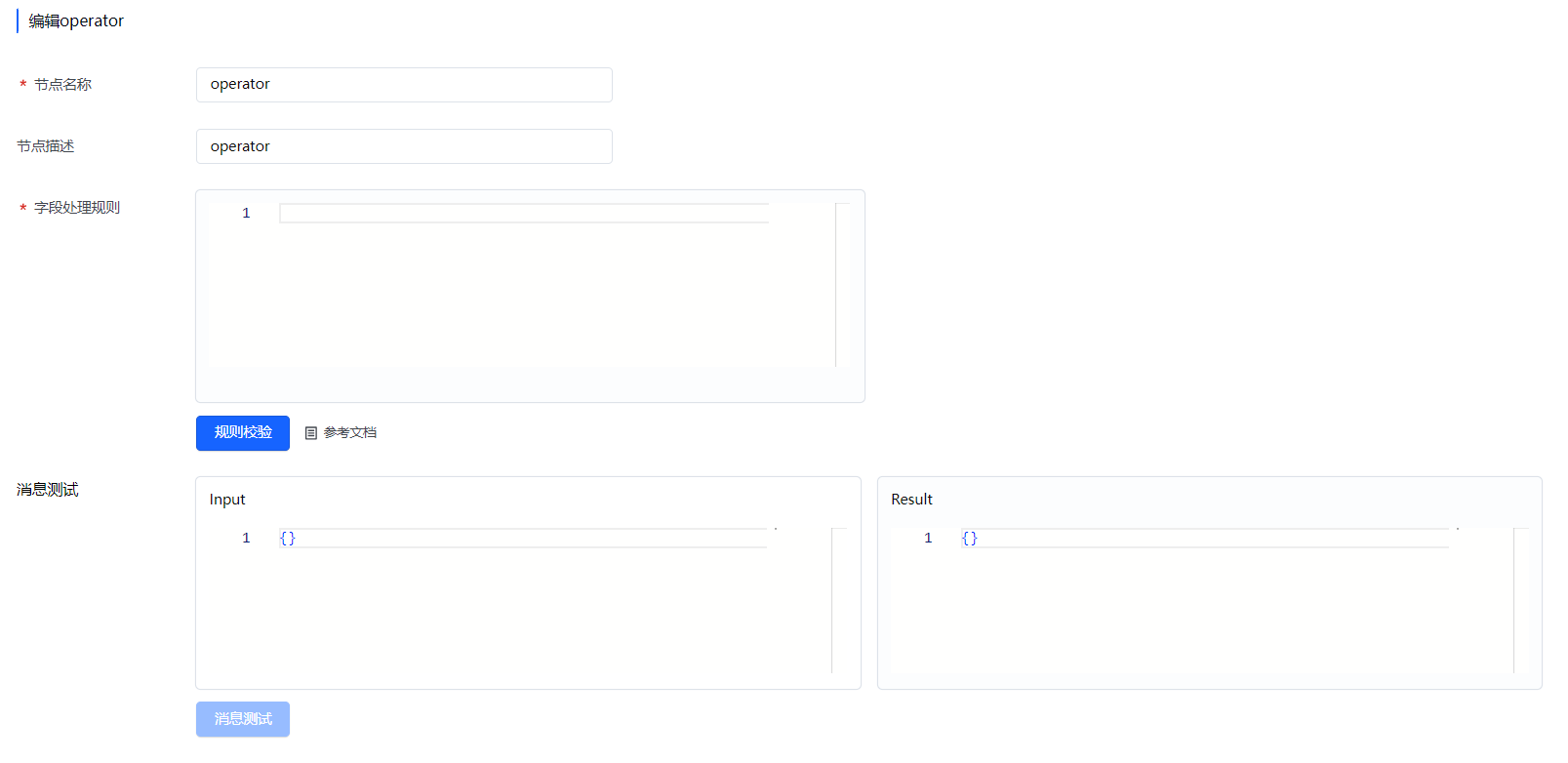

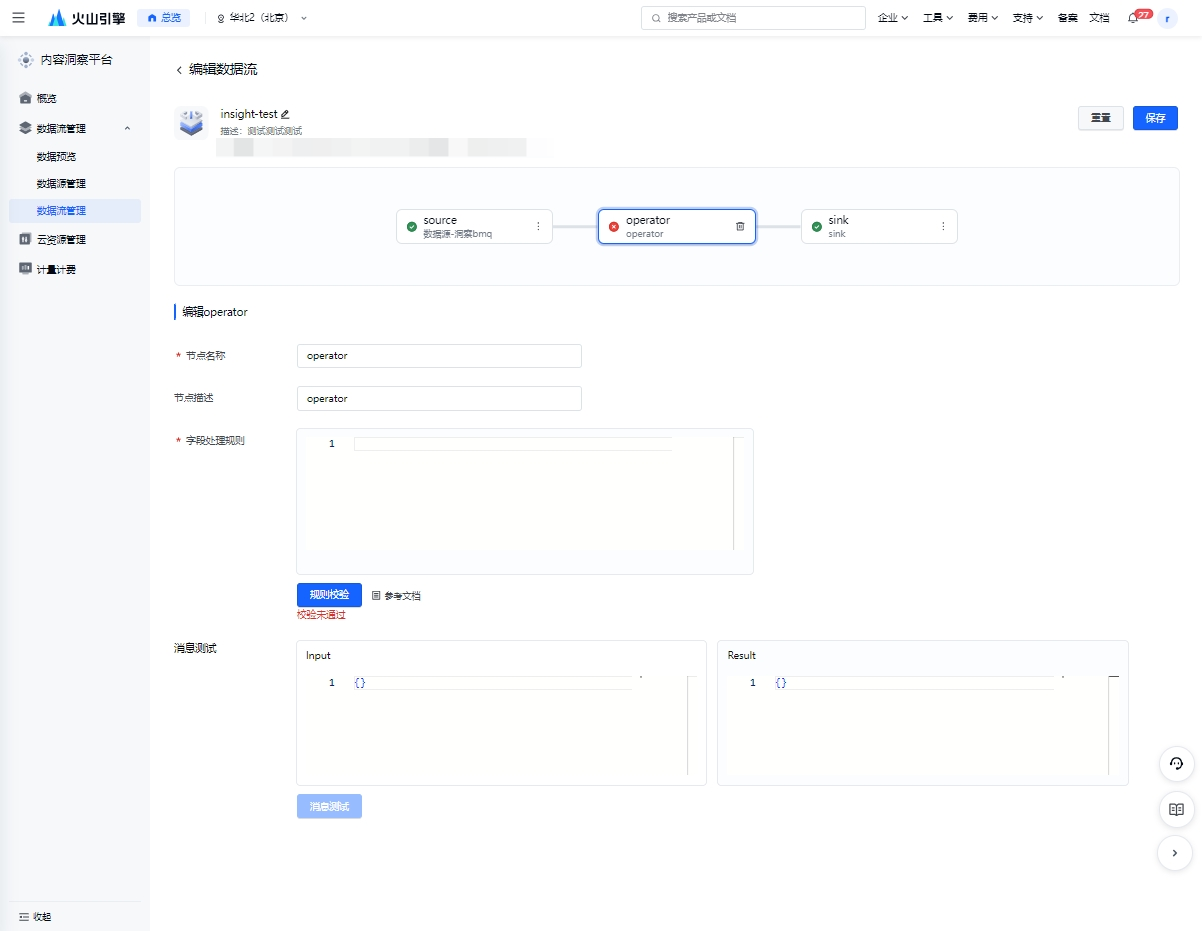

Operator

Operator指数据流中可加入的算子,用于对数据执行某类具体操作,包含字段处理算子和模型算子(建设中)。

注意

PaaS数据结构转化逻辑请查看:数据结构转化样例--内容洞察平台-火山引擎

| 支持算子 | 配置内容 | 详细说明 |

|---|---|---|

字段处理 |

|

|

| 模型算子 | 建设中 | - |

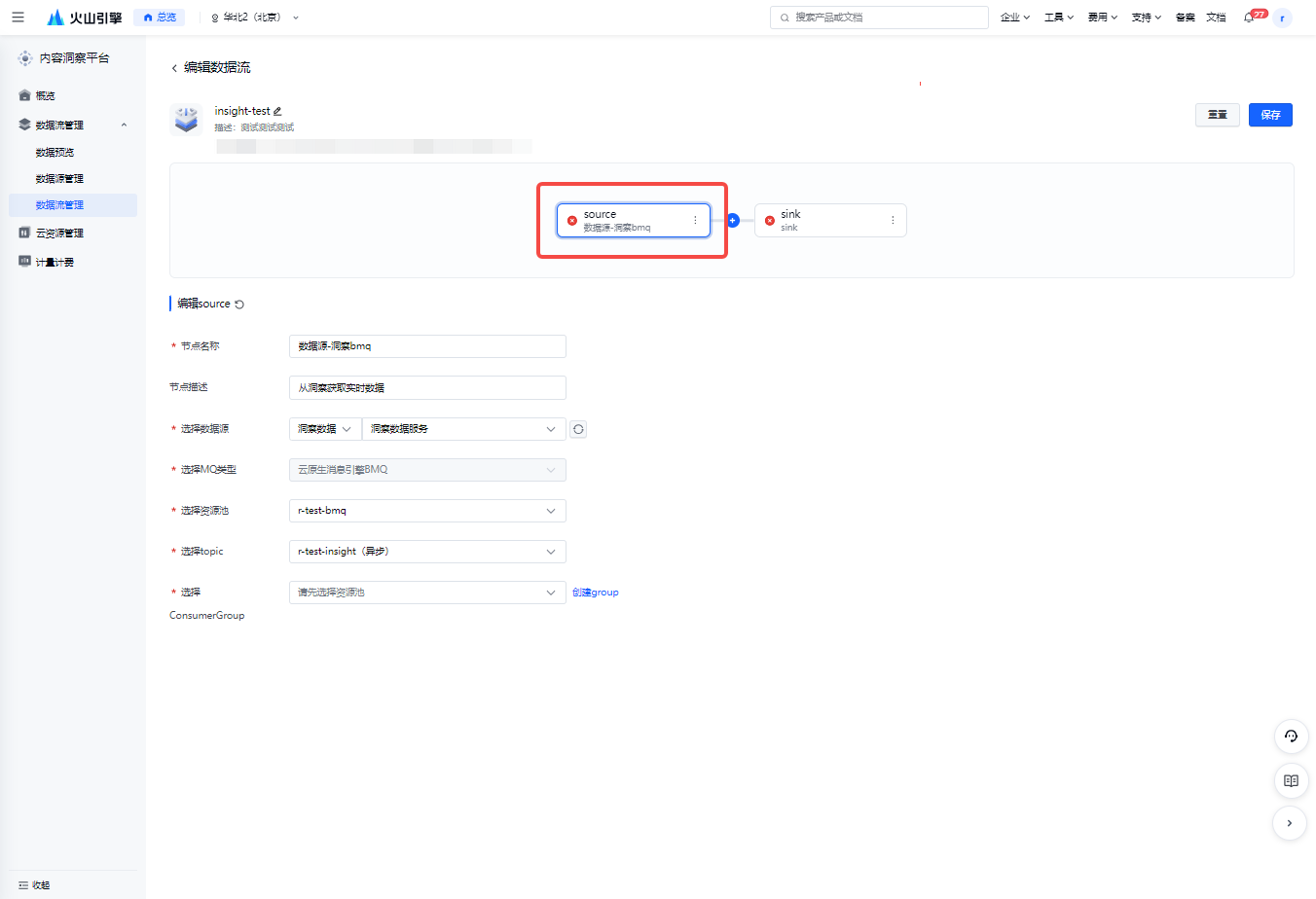

创建/编辑

客户可创建多条数据流,并在数据流画布进行编辑,支持添加、删除、编辑节点。

| 控制台示意 | 说明 |

|---|---|

创建数据流 | 点击数据流管理tab,点击右上角创建数据流按钮,可创建数据流 |

点击任一节点,可进行编辑 | 点击source/sink节点,可按照提示完成编辑。 可在数据流中新增/删除operator节点。 |

校验及发布

数据流发布上线前,还需进行校验,校验通过后才可发布上线。

| 控制台示意 | 说明 |

|---|---|

提交保存,节点标识变更 | 节点编辑完成后,点击保存。 |

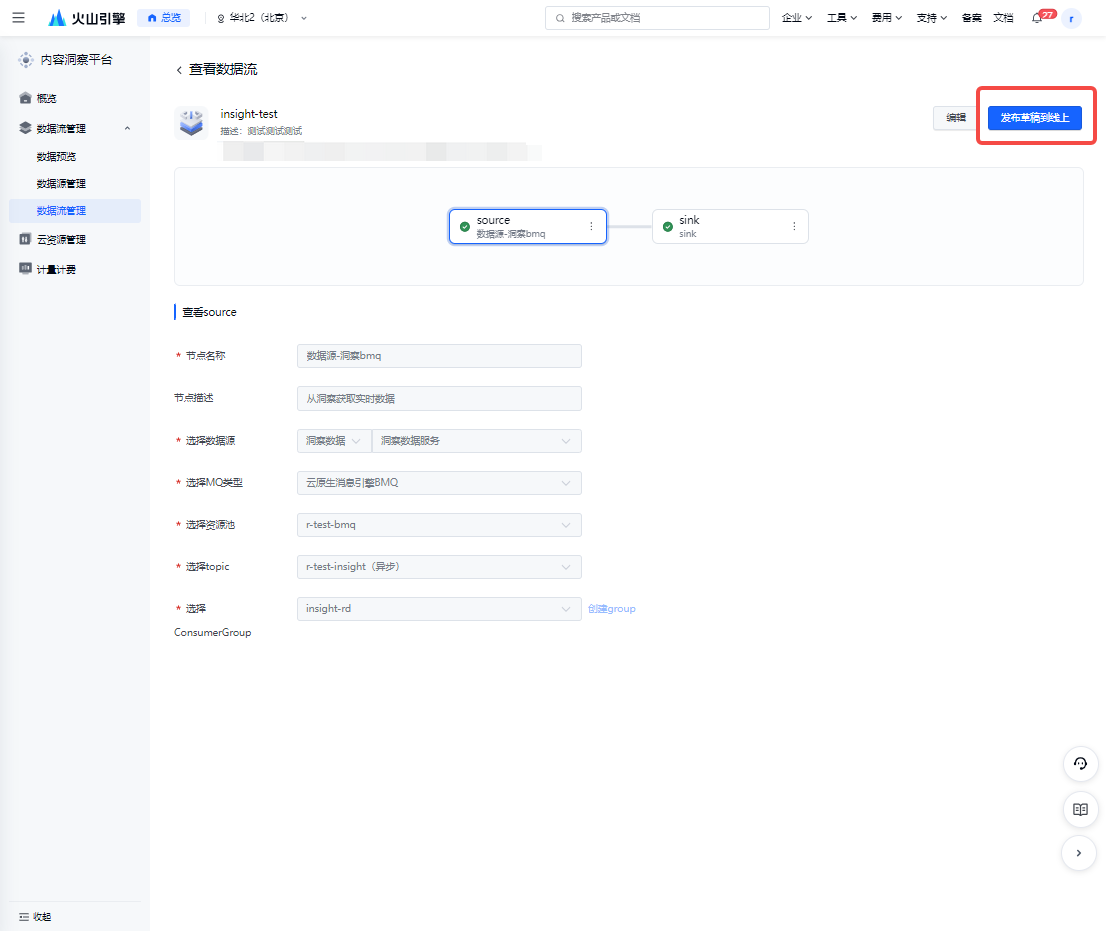

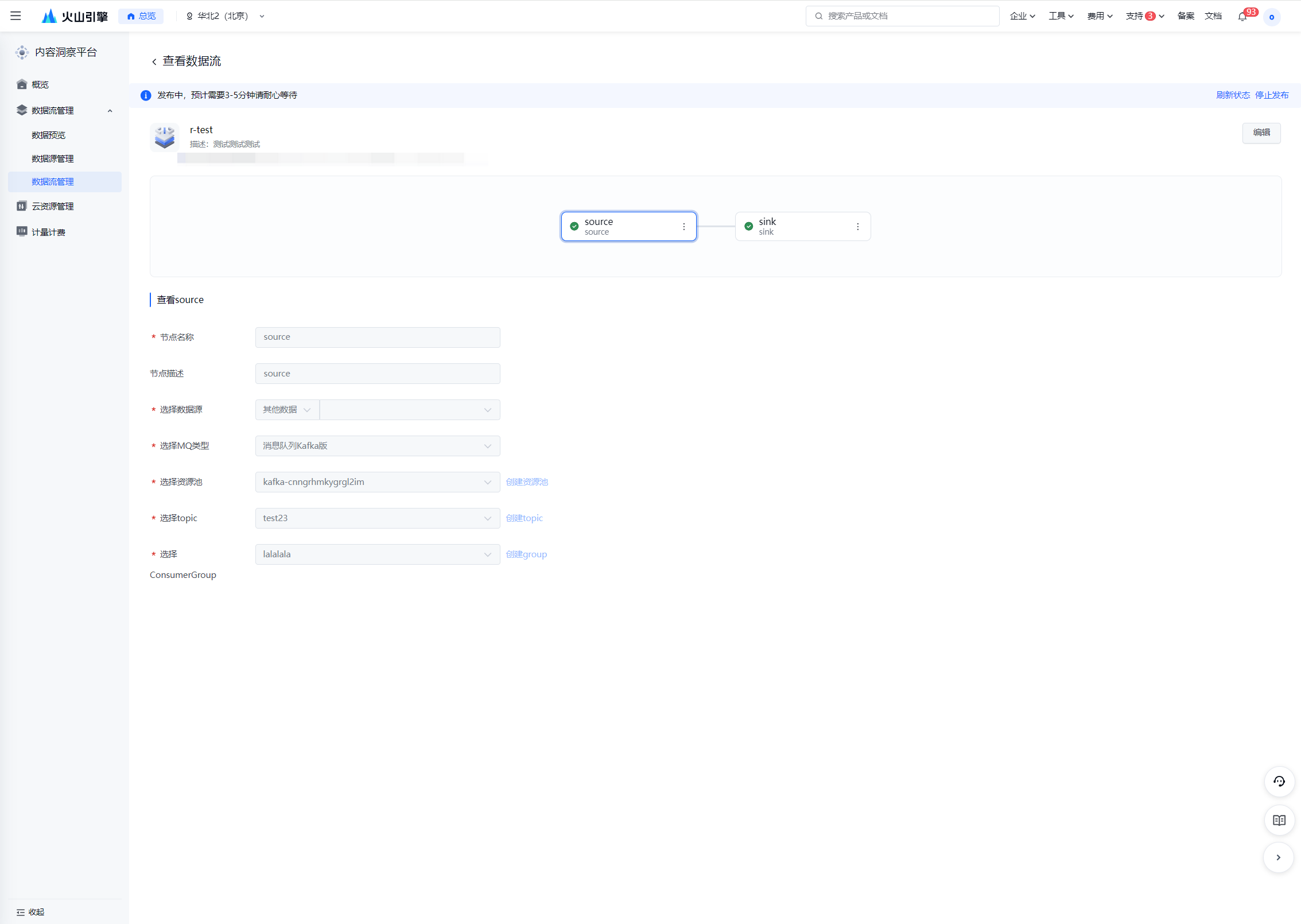

点击发布数据流 | 节点编辑完成,且节点标识提示正确无误的情况下,可点击按钮【发布草稿到线上】发布数据流。 |

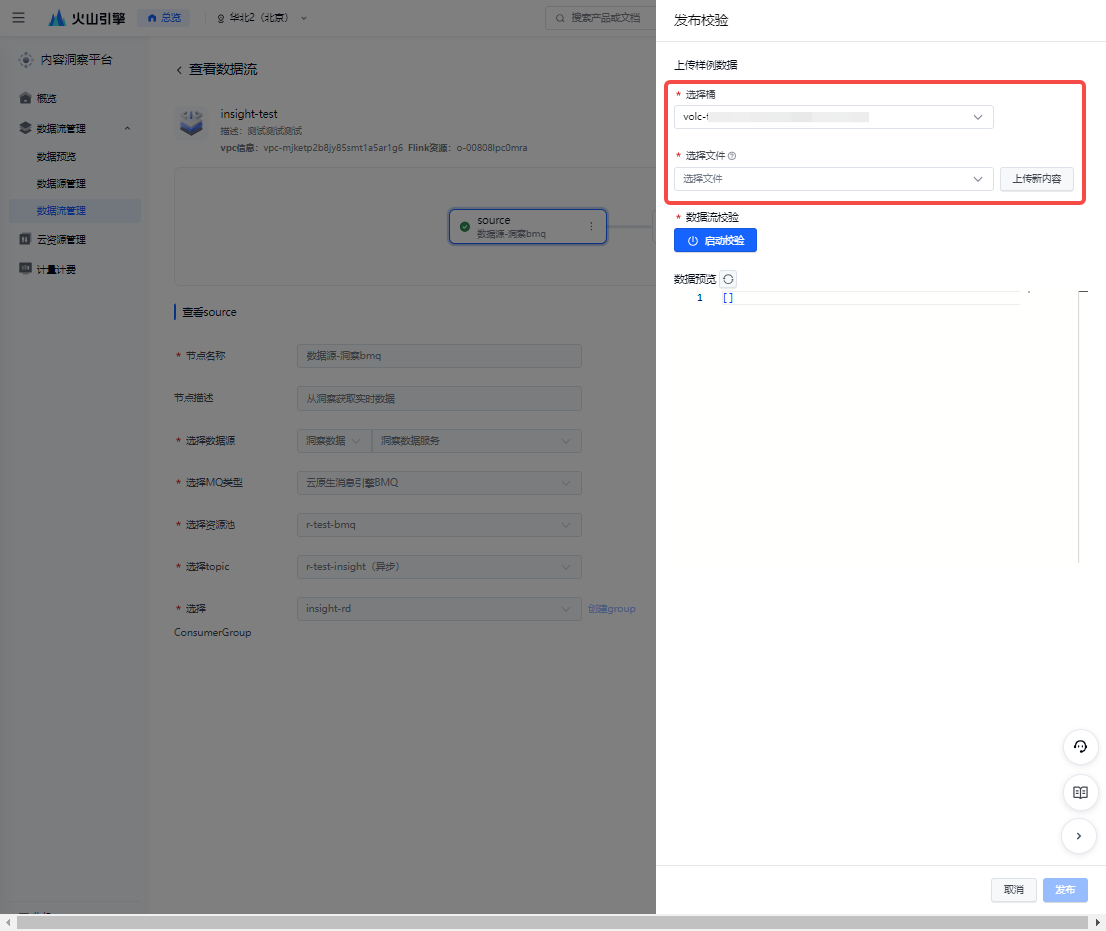

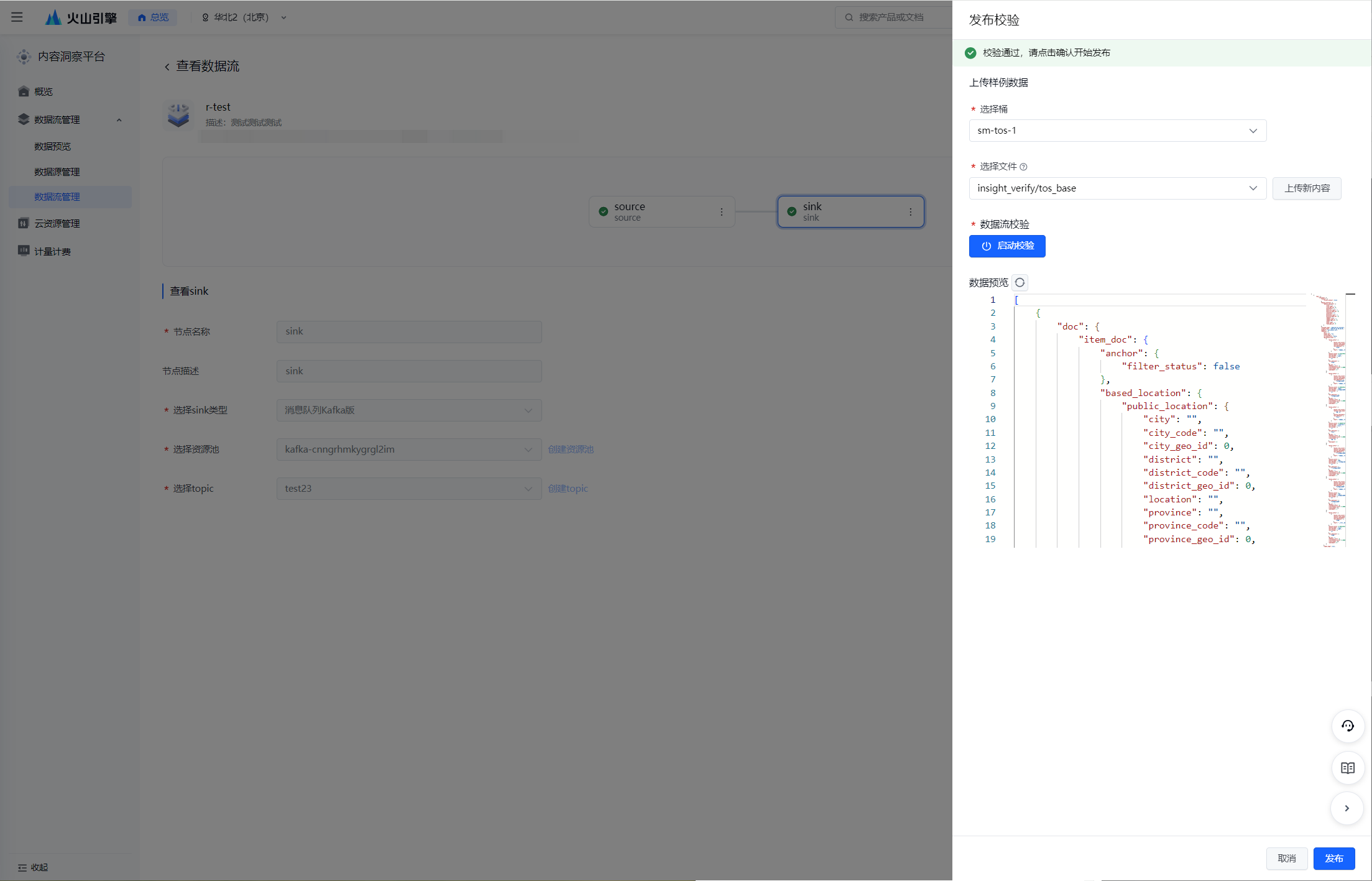

选择TOS桶并上传样例数据 | 发布数据流前需进行发布校验,上传样例数据,以确保数据可正常按照设置写入下游。 选择TOS桶以存储相关文件,并选择/上传将要进行校验的样例数据。 注意:

校验数据样例: 其他数据: |

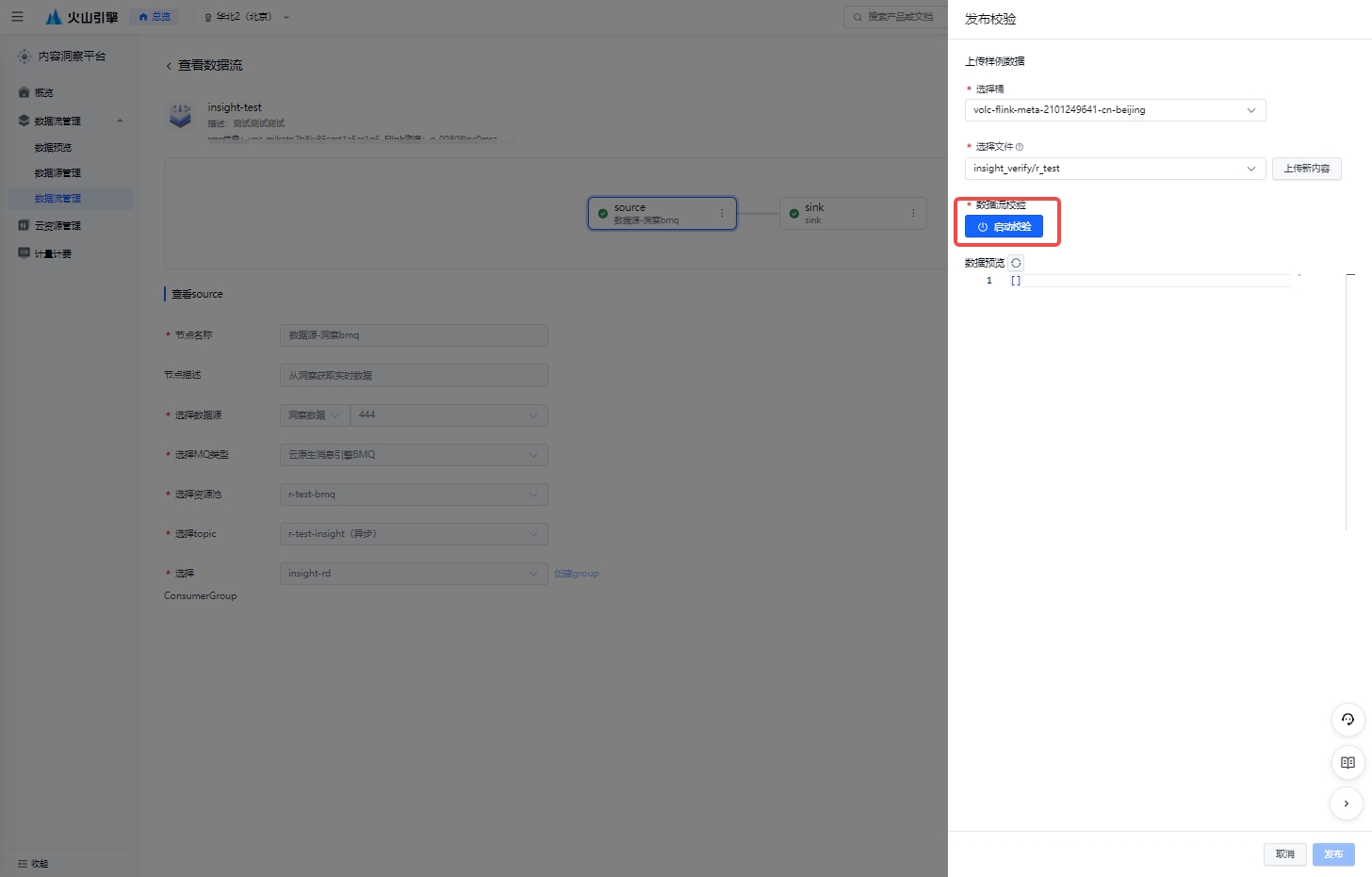

点击启动校验 | 样例数据上传完毕后,点击按钮【启动校验】 |

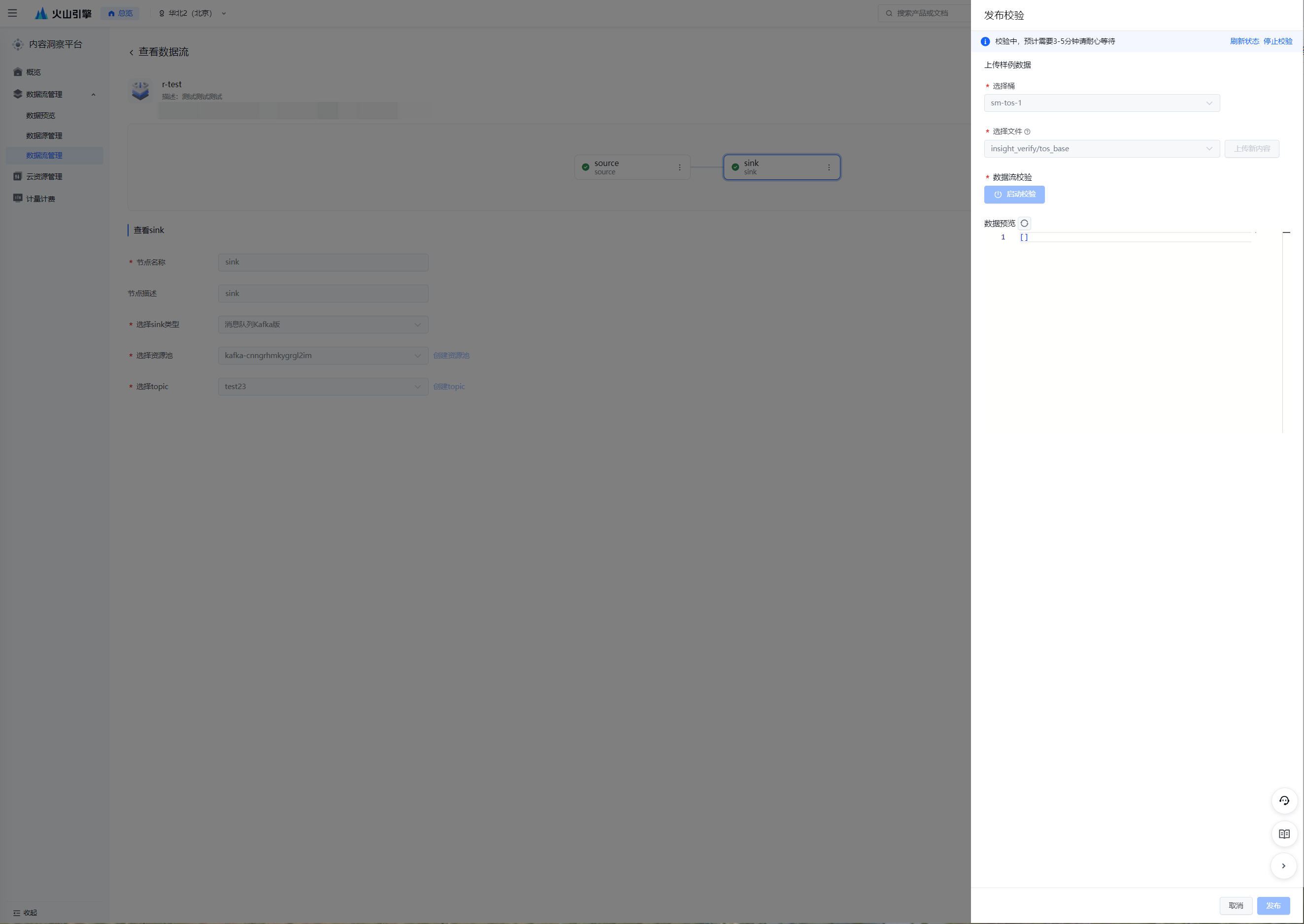

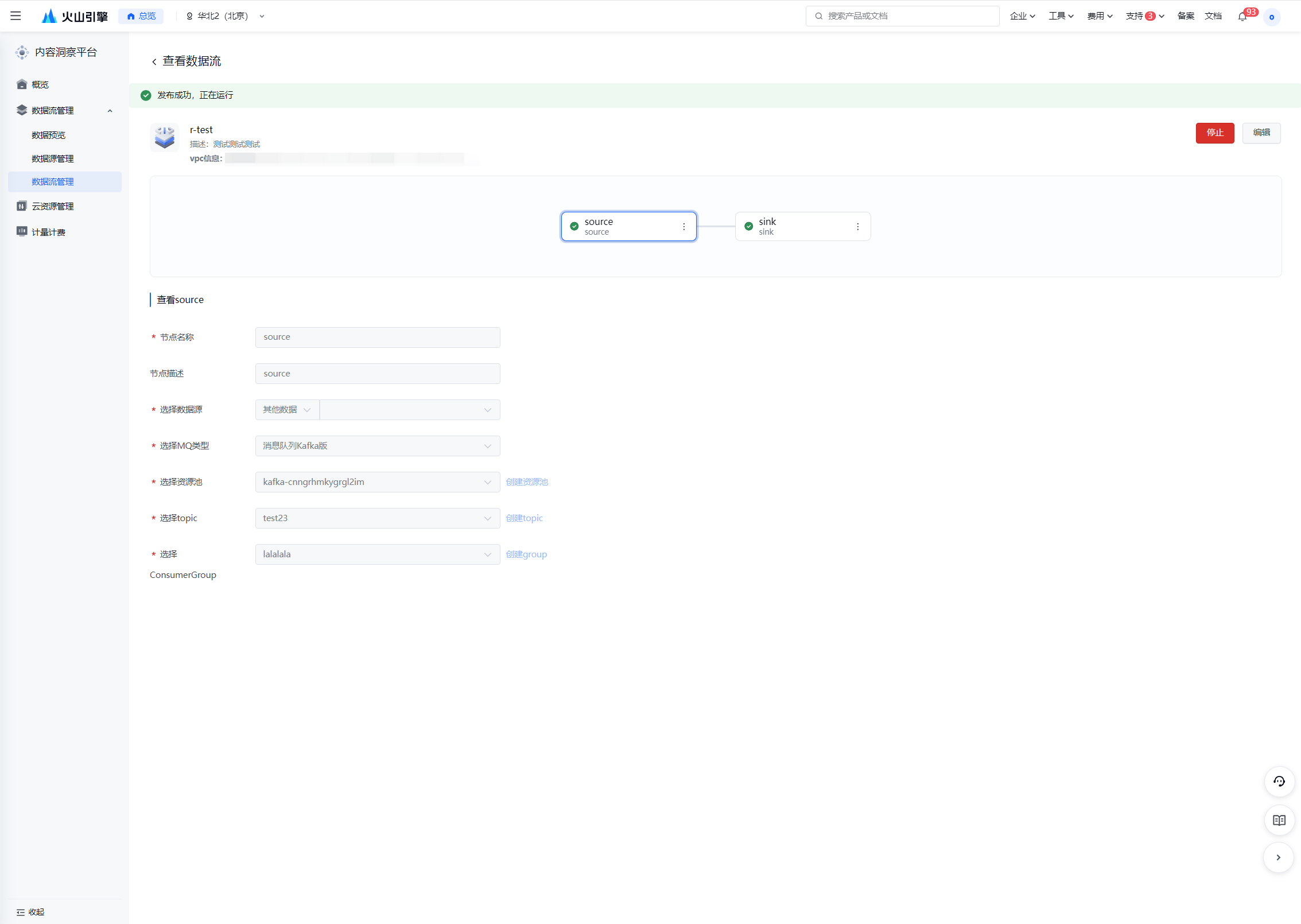

校验通过,发布数据流 | 校验通过后,可查看数据预览,确认无误后可发布数据流。 发布预计需要3-5分钟,请耐心等待。 |