导航

焱融文件存储系统部署及性能验证

最近更新时间:2022.04.27 11:51:52首次发布时间:2021.11.11 11:22:21

该文档介绍焱融文件存储系统在火山引擎弹性计算的本地SSD型ECS实例上进行小型化部署的典型方案,及相关性能验证。

部署场景

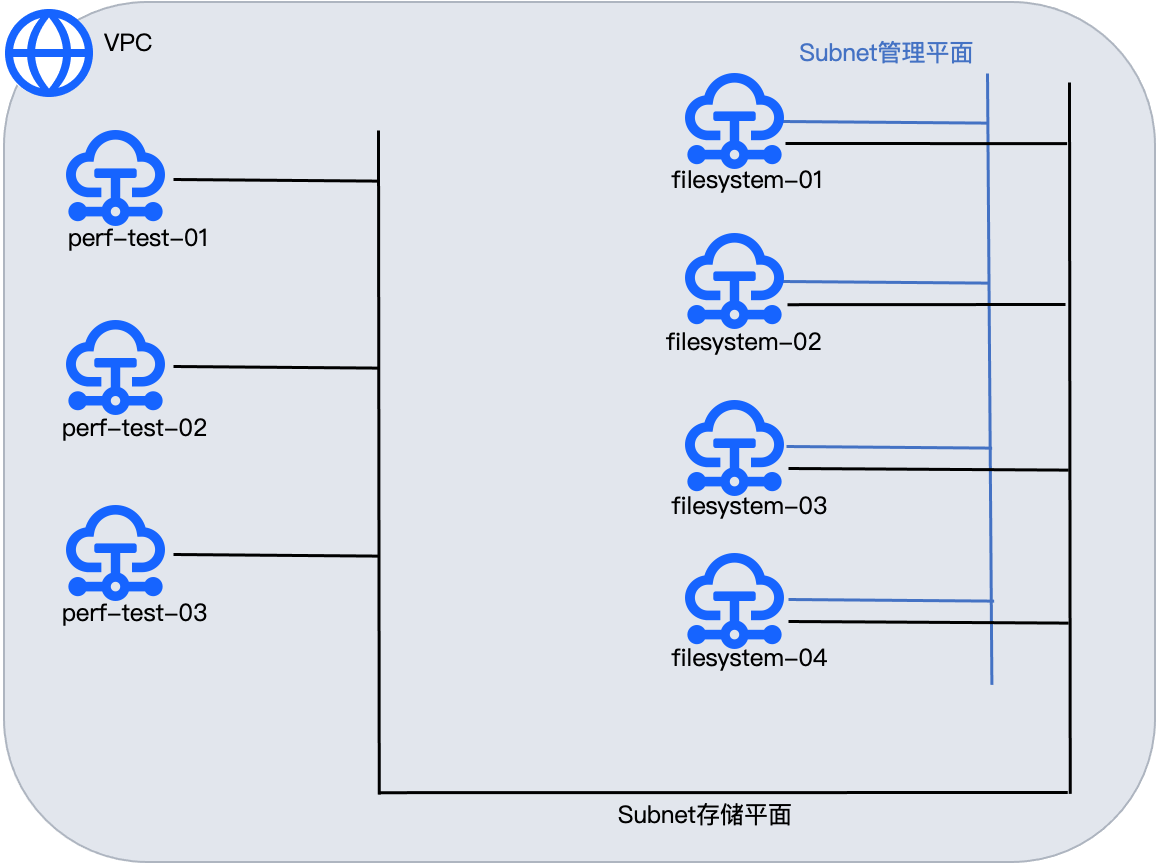

该典型配置使用4台ECS本地SSD型大规格实例用于部署焱融文件存储系统,ECS实例之间通过高速VPC网络连接,节点间的网络带宽最高可达33Gbps。每台ECS实例配置3块本地NVME SSD硬盘和两个弹性网卡(主网卡只做运维逃生通道,辅网卡为存储业务平面)。ECS实例间安全组配置为全互联互通,焱融文件存储系统对外只开放指定端口访问,用于存储系统的配置和运维。

另外,在上述4台ECS本地SSD型大规格实例所在VPC中部署3台高性能ECS实例,作为存储性能测试的读写客户端。该3台高性能ECS测试机为可选部署。在实际的业务部署中,业务系统可以直接在同一VPC中访问焱融的文件系统服务。

部署示意图如下图所示。

前提条件

- 注册火山引擎账号,并完成企业实名认证。您可以登录火山引擎控制台查看是否已经完成实名认证。

- 已创建1个VPC实例,详细步骤参见创建私有网络。

- 已创建4台本地SSD型ECS实例和3台高性能ECS实例,创建步骤参见购买云服务器,各实例的配置数据参见数据规划。

数据规划

焱融存储节点

示意图中ECS实例filesystem-01、filesystem-02、filesystem-03、filesystem-04的规格选型均参考下表。实例规格vCPU 内存

(GiB)本地存储(GiB) 网络带宽(Gbit/s) 网络收发包(万PPS) 连接数(万) 多队列 云盘IOPS(万) 云盘带宽(Gbit/s) ecs.i1.14xlarge 56 352 3726 * 3 33 400 400 32 20 10 性能测试节点

示意图中ECS实例perf-test-01、perf-test-02、perf-test-03的规格选型均参考下表。实例规格vCPU 内存

(GiB)网络带宽(Gbit/s) 网络收发包(万PPS) 连接数(万) 多队列 云盘IOPS(万) 云盘带宽(Gbit/s) ecs.g1.22xlarge 88 352 33 400 400 64 20 10

部署步骤

如需部署,请联系火山引擎技术支持团队或者直接联系焱融官方技术支持,更多关于焱融存储系统的信息请访问:https://www.yanrongyun.com/zh-cn/products/yrfs。

性能验证

验证环境信息(焱融存储节点)

| 序号 | 实例名称 | 服务器名 | 角色 | 存储集群网络 |

|---|---|---|---|---|

| 1 | filesystem-01 | filesystem1.byte | 管理节点/元数据节点/数据节点 | 192.168.0.57 |

| 2 | filesystem-02 | filesystem2.byte | 元数据节点/数据节点 | 192.168.0.71 |

| 3 | filesystem-03 | filesystem3.byte | 管理节点/元数据节点/数据节点 | 192.168.0.26 |

| 4 | filesystem-04 | filesystem4.byte | 管理节点/元数据节点/数据节点 | 192.168.0.23 |

性能验证结果

- 测试环境

- 存储读写压测客户端3台ECS。

- 4台ECS部署的焱融文件存储系统,提供可用的文件系统容量17.6TB。

- 读写客户端与文件存储系统在同一VPC中,ECS的弹性网卡带宽限制为33Gbps。

- 测试场景

使用fio工具,多场景下同时从3台ECS压测焱融文件存储系统,观测其IOPS性能及IO带宽。 - 测试用例及结果

- 并发4K块随机读,观测集群IOPS

结果:读IOPS 906342 次/s - 并发4K块随机写,观测集群IOPS

结果:写IOPS 282640 次/s - 并发512K块顺序读,观测集群IO带宽

结果:读带宽 6.8 GB/s - 并发512K块顺序写,观测集群IO带宽

结果:写带宽 3.9 GB/s

- 并发4K块随机读,观测集群IOPS

- 测试总结

以火山引擎ECS本地SSD型实例、高速私有网络等为基础设施部署的焱融文件存储系统,提供了性能极佳的云上文件存储系统。

名词解释

| 名词 | 说明 |

|---|---|

| 焱融存储系统 | YRCloudFile通过市场上标准的X86服务器为AI用户构建一套容量与性能可无限水平扩展的分布式文件存储,可承载数百亿个几十KB的小文件,为深度学习平台上万个客户端提供并发访问支持,满足AI训练中GPU或CPU计算集群的高带宽、低延时的小文件访问特性,使GPU等计算资源得到最大程度的利用,在数十亿文件数量下仍然能够提供稳定的数据访问性能,有效提升训练效率。 |

| 本地SSD型ECS实例 | 本地SSD型规格配备高性能SSD本地直通盘,具有高容量、低I/O延迟、高IOPS特点,能够提升文件读写性能、高速作业效率,适用于有海量数据存储、较高存储性能要求的场景。 |