导航

GPU服务器使用

最近更新时间:2023.12.26 10:46:33首次发布时间:2022.04.11 11:22:49

本文将介绍如何创建并使用GPU云服务器。

前言

GPU云服务器(GPU Compute service)是提供 GPU 算力的弹性计算服务,拥有超强的计算能力,能高效服务于机器学习、科学计算、图形处理、视频编解码等多种场景,本文将介绍如何创建并使用GPU云服务器。

关于实验

- 预计部署时间:30分钟

- 级别:初级

- 相关产品:GPU云服务器

- 受众: 通用

环境说明

实验步骤

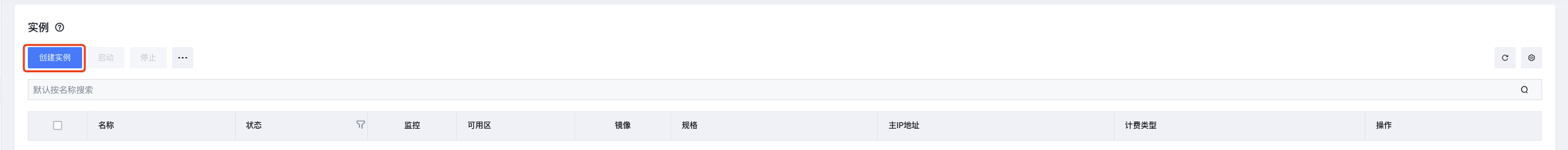

步骤1:创建GPU实例

- 进入到云服务器管理界面ECS实例控制台

- 点击创建实例。

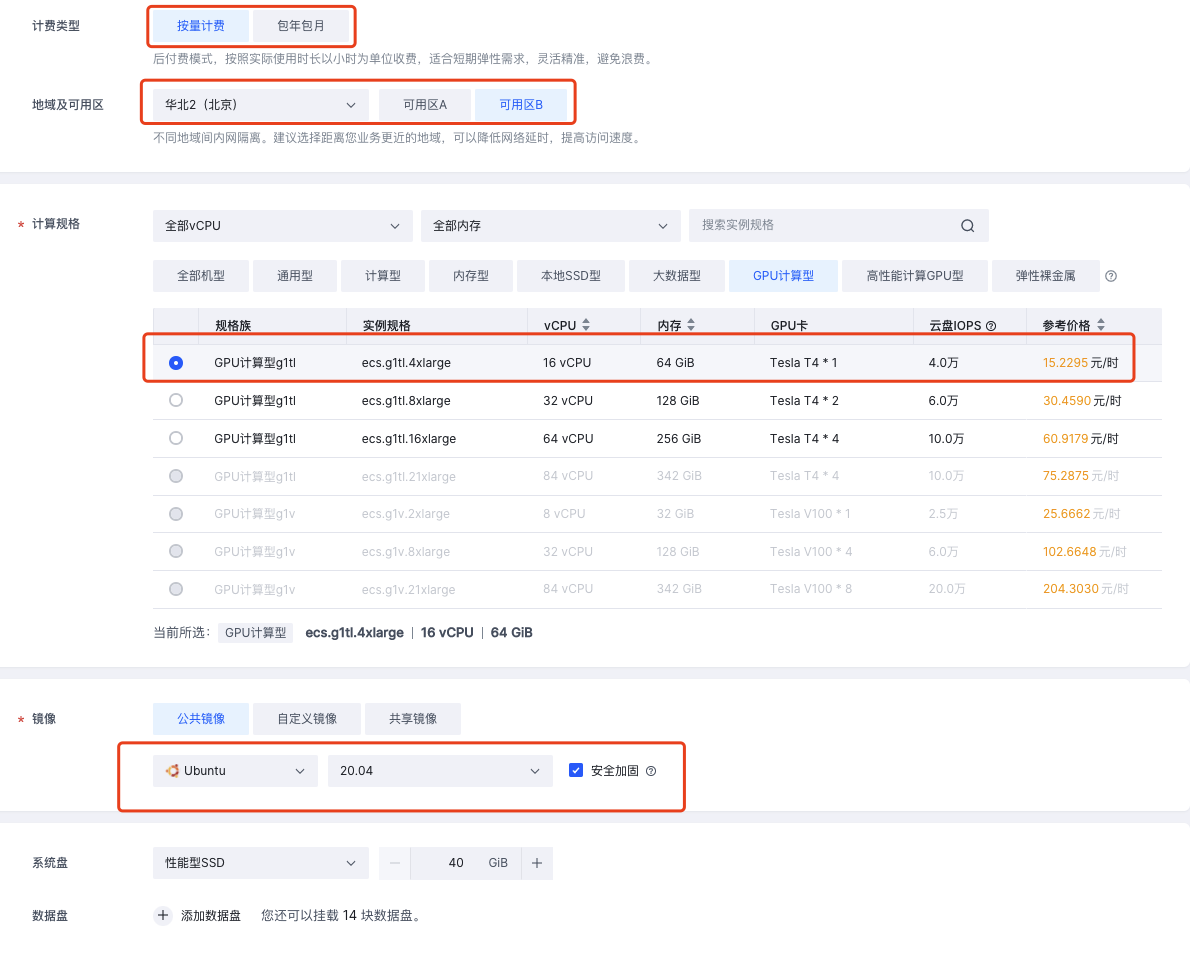

- 选择“计费类型” ---> 选择“地域及可用区” ---> 选择“GPU计算型” ---> 选择“GUP实例规格” ---> 选择“镜像及其版本” ---> 点击“确定”。

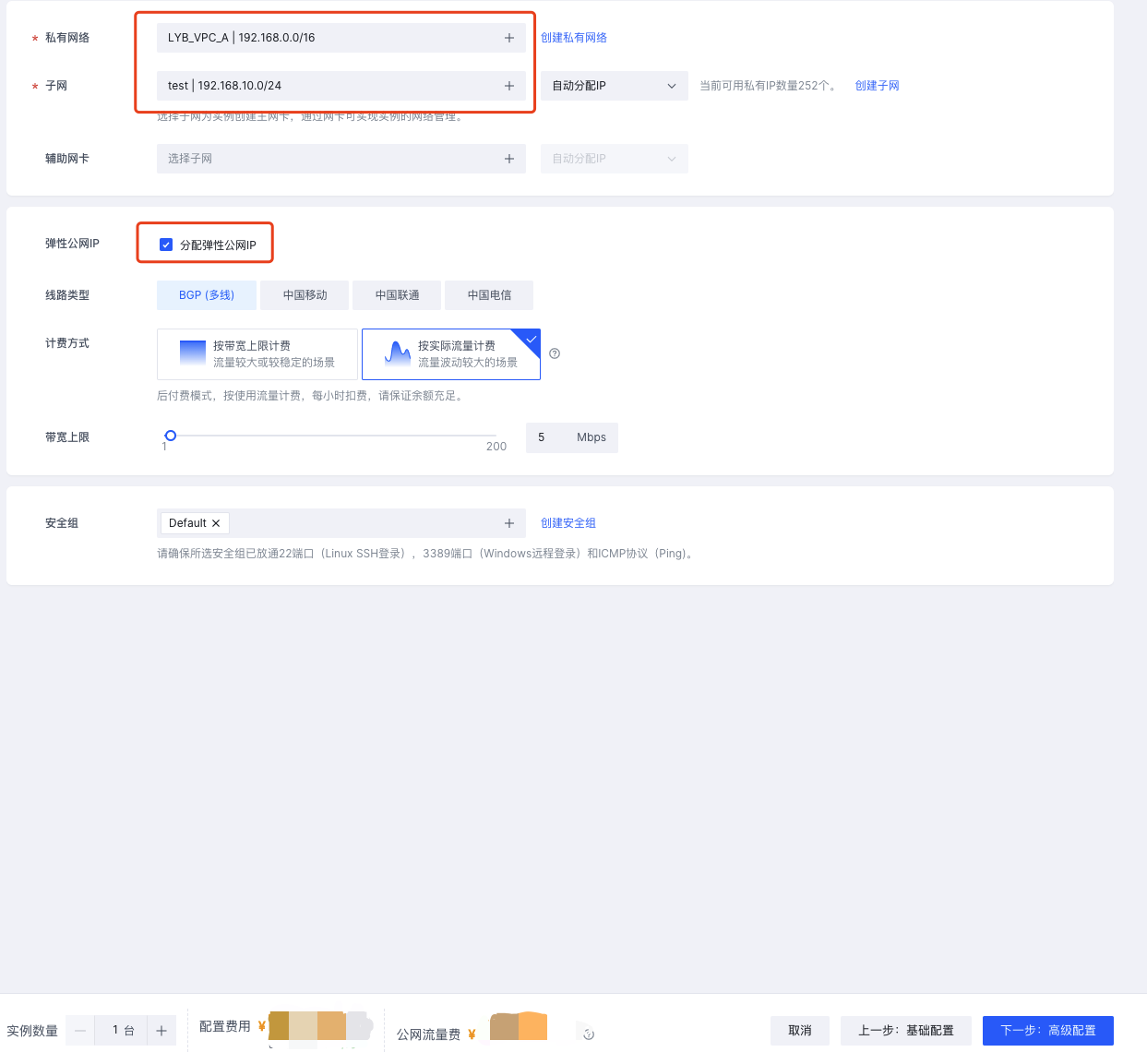

- 选择“私有网络” ---> 选择“分配弹性公网IP”,根据实际需求选择计费类型以及带宽大小,点击“下一步:高级配置”。

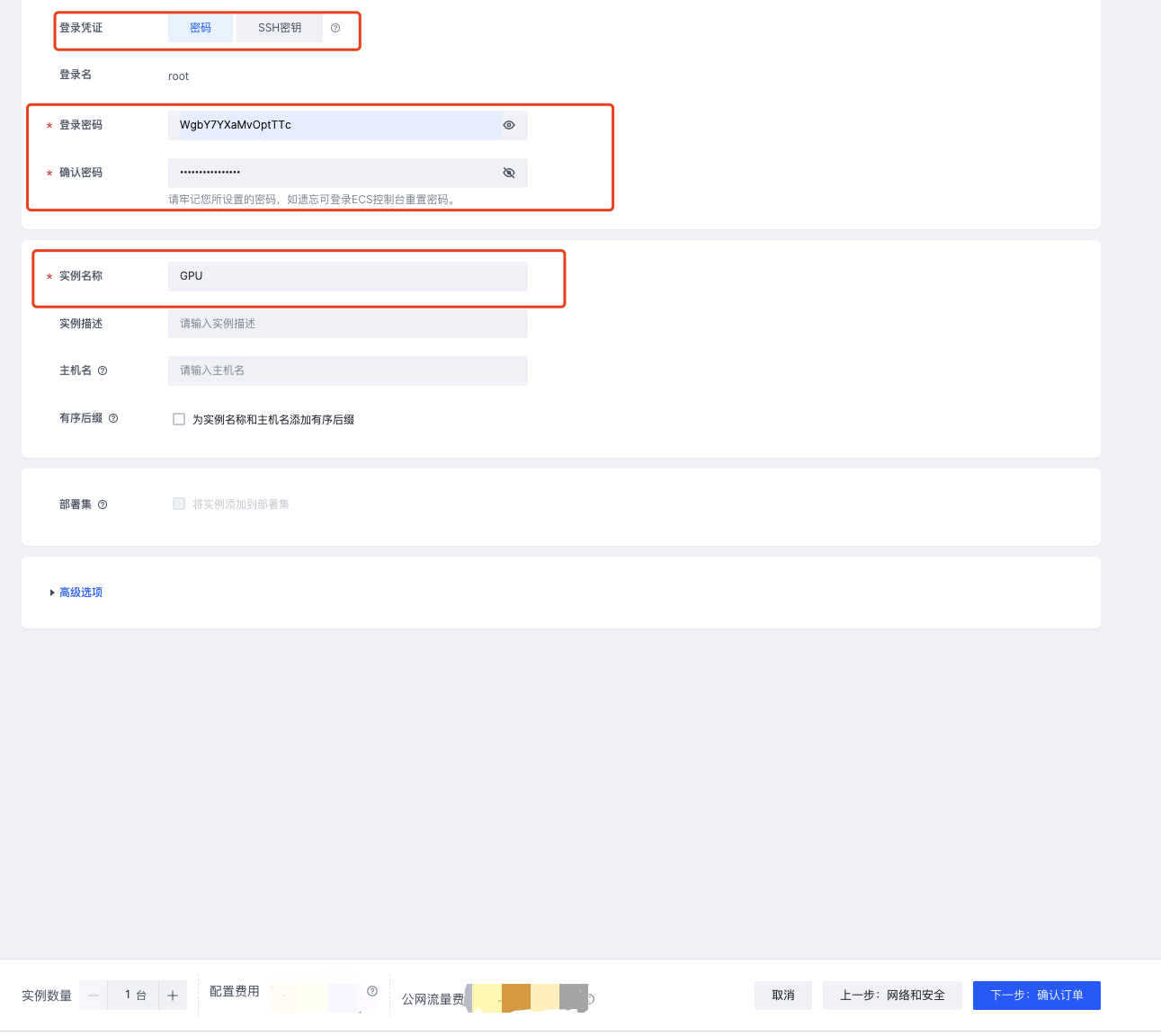

- 选择“登录凭证” ---> 输入“登录密码” ---> 输入“实例名称” ---> 点击“下一步:确认订单”。

步骤2:安装CUDA Toolkit

具体安装步骤请参英伟达CUDA安装说明

步骤3:安装GPU_BURN

- GPU_BURN下载以及使用方法参考文档GPU_BURN下载以及使用方法

- 安装GPU_BURN,使用如下命令。

tar zxvf gpu_burn-1.1.tar.gz

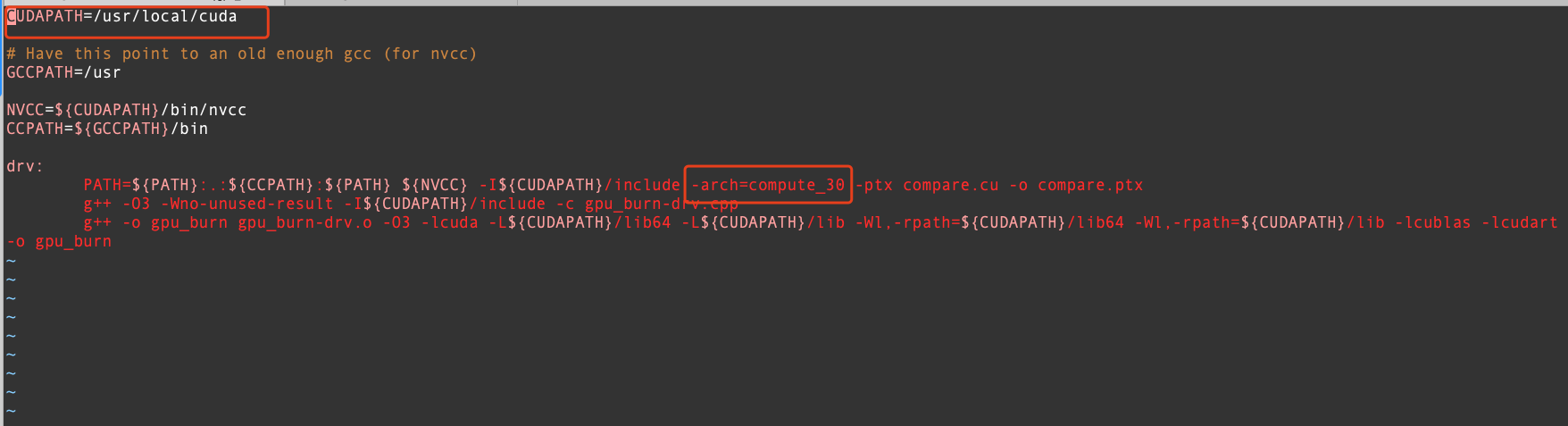

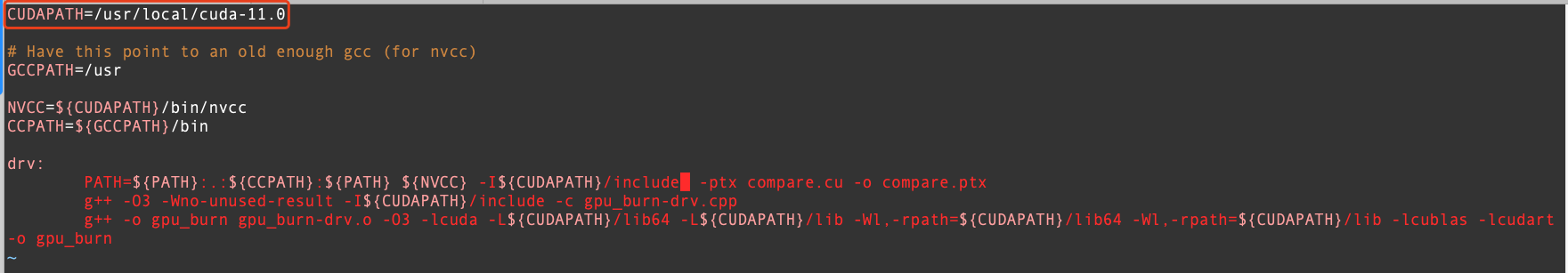

- 编辑Makefile,

CUDAPATH=/usr/local/cuda这里需要更改为自己安装cuda的位置即可,删除-arch=compute_30。

编辑后的配置文件如图所示。

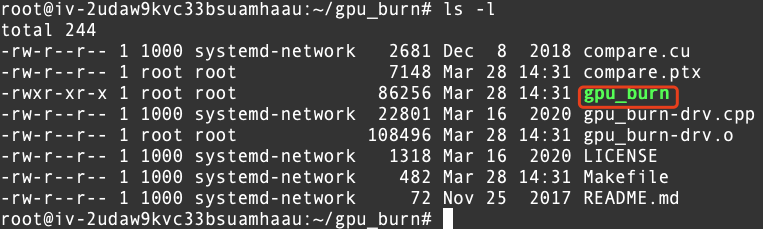

- 执行

make命令,生成gpu_burn可执行文件,具体如图所示。

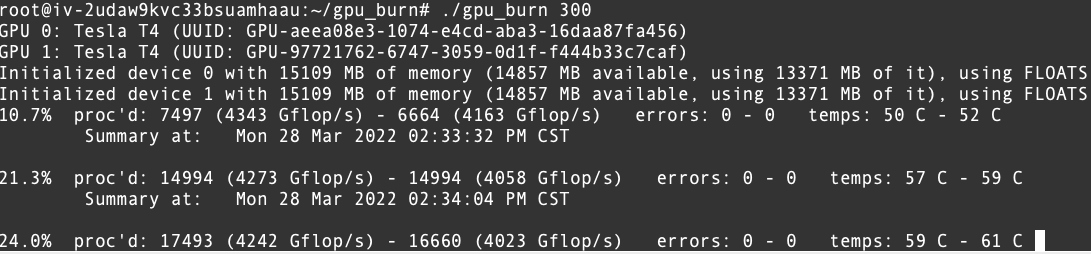

步骤4:使用GPU_BURN对GPU卡进行压测

- 执行命令

./gpu_burn 300执行结果如下。

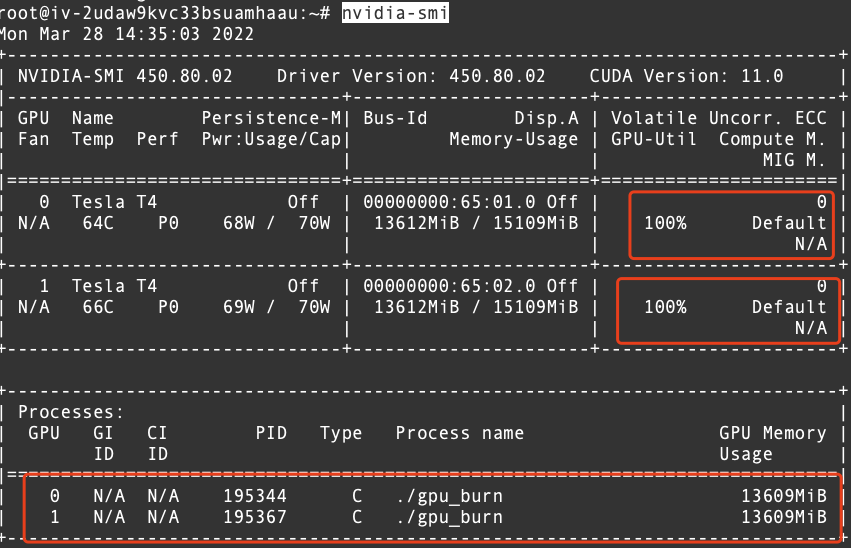

- 打开其他终端,执行命令

nvidia-smi执行结果如下。