导航

3.4.1 Kafka-Hdfs

最近更新时间:2022.09.05 11:25:31首次发布时间:2022.09.05 11:25:31

使用场景

将kafka数据同步至hdfs,实现kafka数据源与hdfs之间的数据实时传输。

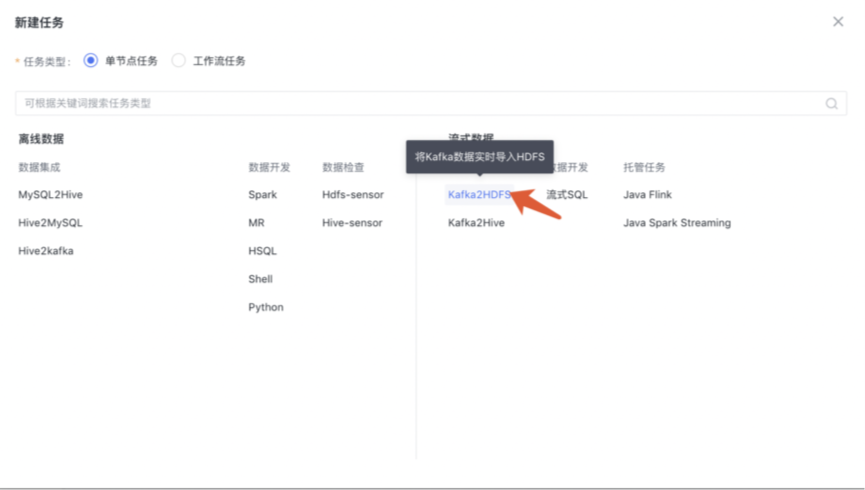

新建任务

1. 在任务开发首页,点击“新建任务”

2. 在项目下,左侧目录结构中,右键新建任务

任务配置

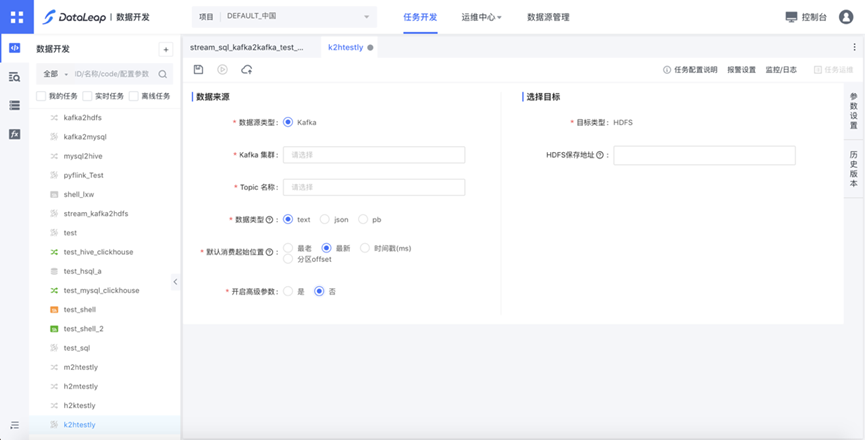

数据源信息

- Kafka:选择Kafka集群和Topic。

- 数据类型:支持 text、json、pb。

- 默认消费起始位置:任务首次上线需要指定消费位置,在Flink job 没有checkpoint, 且重启/启动未指定重置offset方式时生效。

- 高级参数:支持并发度、压缩格式、副本数等配置,默认关闭。

目标源信息

文件保存地址,输入HDFS Path。

参数配置

基础信息:任务名称、描述、责任、队列等。

资源设置 :

1. 一般场景下使用默认参数即可

2. 获取推荐配置:根据任务的历史24小时运行情况,给出推荐配置

Flink 运行参数 :Flink 相关的动态参数和执行参数,具体设置详见Flink官方文档。

用户自定义参数 :kv格式,非必填。

提交上线

任务测试通过后,先“保存”任务生成一个草稿版本。然后点击”提交上线“,即按最新的版本启动一个 Flink 实例。任务运维可在“实时任务运维”中操作。

若在运维列表的“重启”任务,默认按线上配置重启,而非最新版本草稿。

历史版本

每次上线会生成一个版本,在“历史版本”功能中可以查看、对比和回滚,回滚的效果是恢复至草稿,需要重新点击上线。

常见问题

怎么配置任务堆积报警

答:流式通道任务的报警统一在任务运维界面设置,任务上线后进入任务运维页面配置堆积报警任务消费能力不足,Lag比较严重

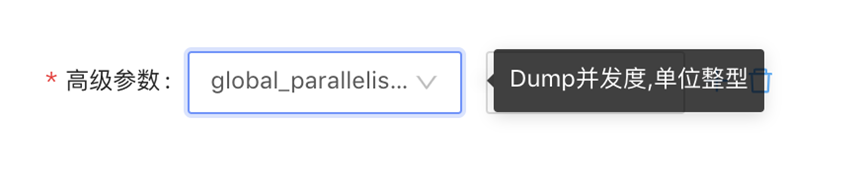

答:任务页面开启高级设置,人工指定并发数,默认并发数为消息队列分区数/

产生的文件较小

答:方案优先级由高到低如下:- 减小任务并发:开启高级参数-高级参数-global_parallelism_num

- 增加Checkpoint间隔时间:开启高级参数-高级参数-checkpoint_interval,单位milliseconds,默认为15min

- 增大rolling file 大小:开启高级参数-高级参数-rolling.max_part_size,文件切割大小,单位字节,默认大小10G(PS:计算方式为压缩前的大小)。