Ray On MLP 是火山引擎机器学习平台上全新推出的分布式计算引擎选项。利用这一强大的引擎,算法工程师可以轻松通过 python 和 Ray AI Runtime 进行大规模数据处理以及分布式模型训练。火山引擎机器学习平台(MLP)专注于为客户提供端到端的机器学习服务,以帮助客户构建可靠高效的机器学习流程。现在我们更进一步,将 Ray 框架(ray.io) 与 自定义任务模块完美整合,帮助您轻松创建和运行 Ray 作业,实现作业的灵活调度,按需执行。

在使用 Ray On MLP 时,您无需进行任何的代码更改或调整任何资源,只需要使用预置的 Ray 镜像或者使用携带包含 Ray Runtime 的自定义镜像,即可一键运行 Ray 作业。您亦可通过 MLP 中的开发机模块连接到您的 Ray 引擎,以进行相关的任务开发和调试。Ray On MLP 预览版现已在所有地区推出,这意味着您可以在全球范围内利用这一强大的分布式计算引擎,轻松应对不同地域和场景的分布式挑战。

- 不支持任务诊断功能,但支持自动重试。

- 实例保留时长功能中不支持倒计时显示。

- Ray Dashboard 中 Metrics 功能的启用需要用户对接自己的 Grafana。

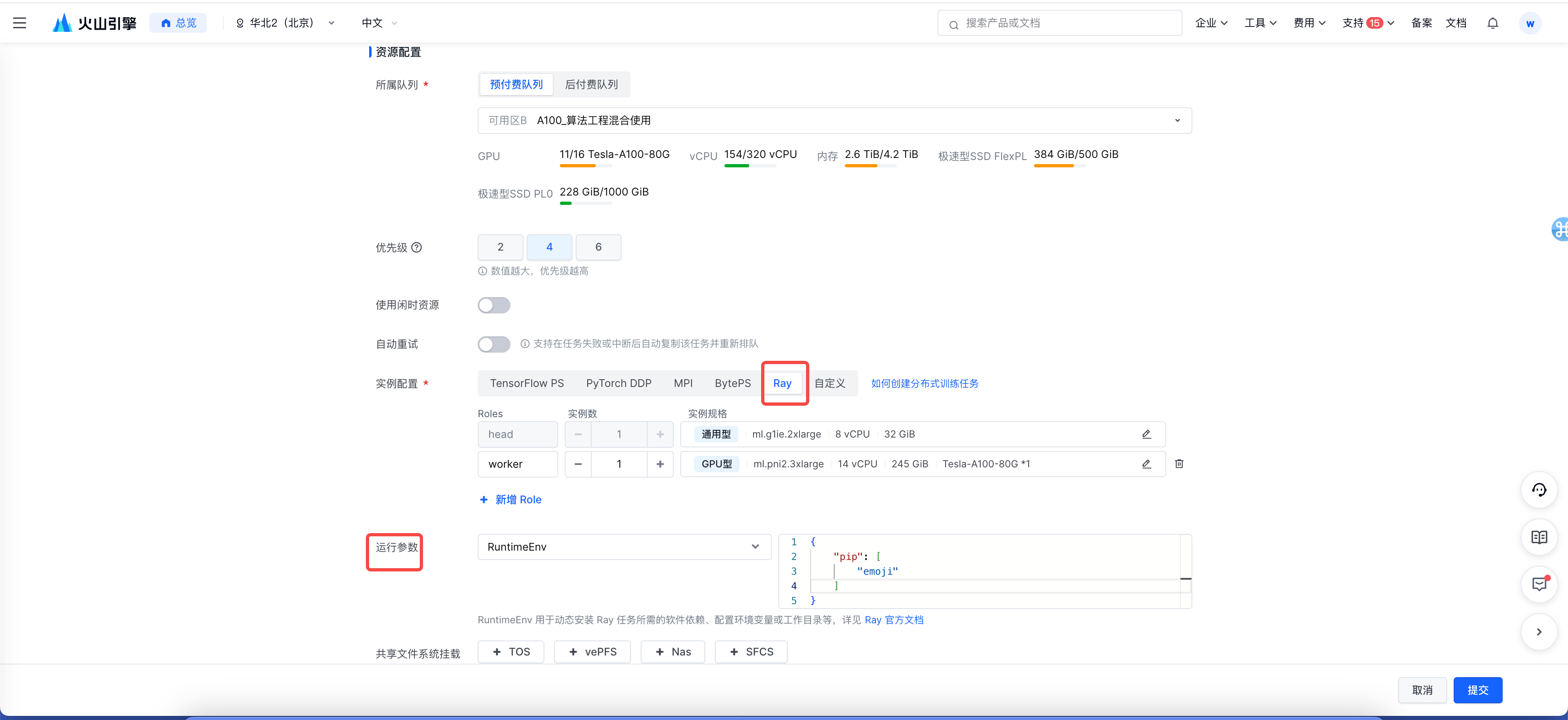

创建 Ray 集群

点击「自定义任务」进入列表页面,点击「创建自定义任务」。

依次进行任务配置,镜像需选择确保存在 Ray 相关的二进制文件,并符合版本要求(2.2.0~2.32.0)

选择 Ray 框架,并选择对应的机型。可针对您 driver 所需要的运行环境填写 RuntimeEnv,以及根据作业需求挂载相应的存储。

- 备注: 当前版本不支持任务诊断与容错功能。

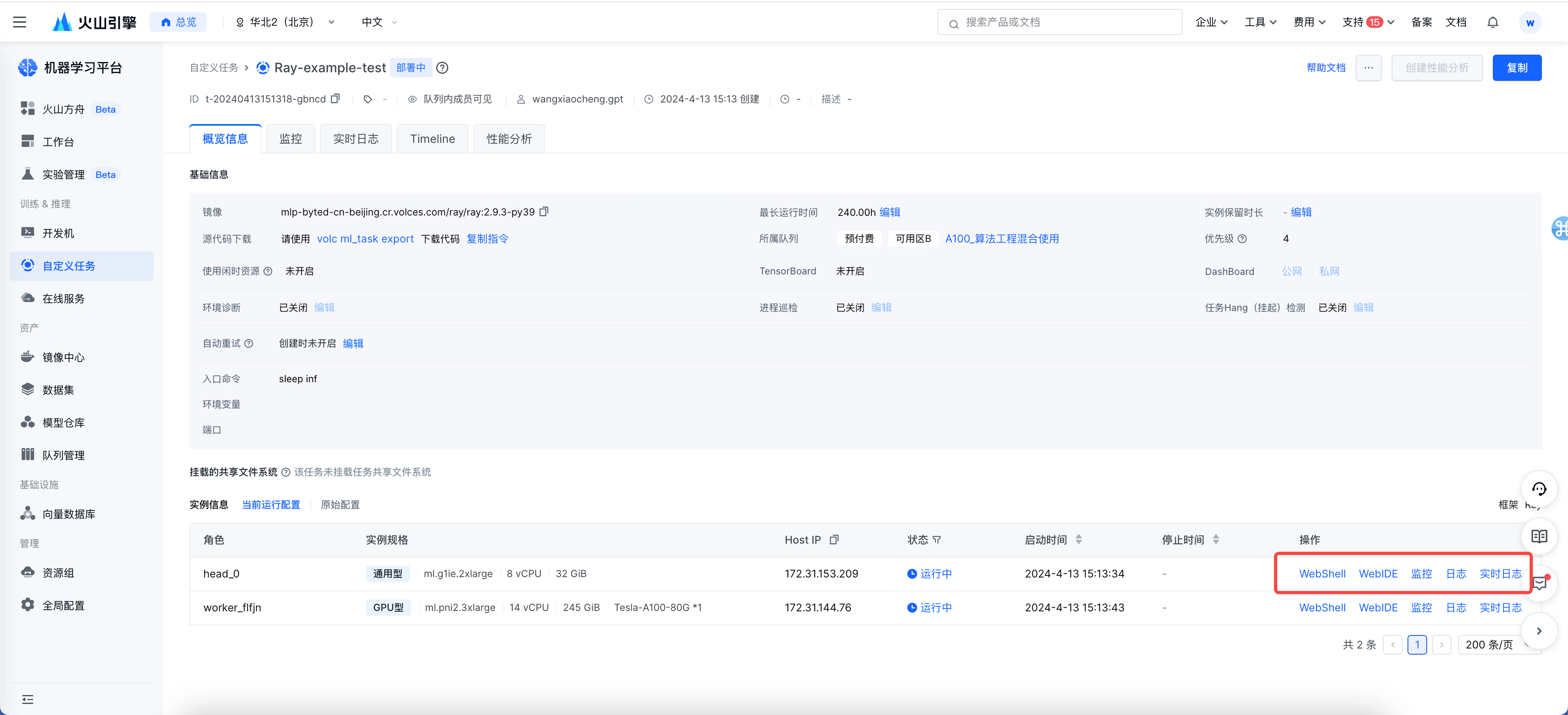

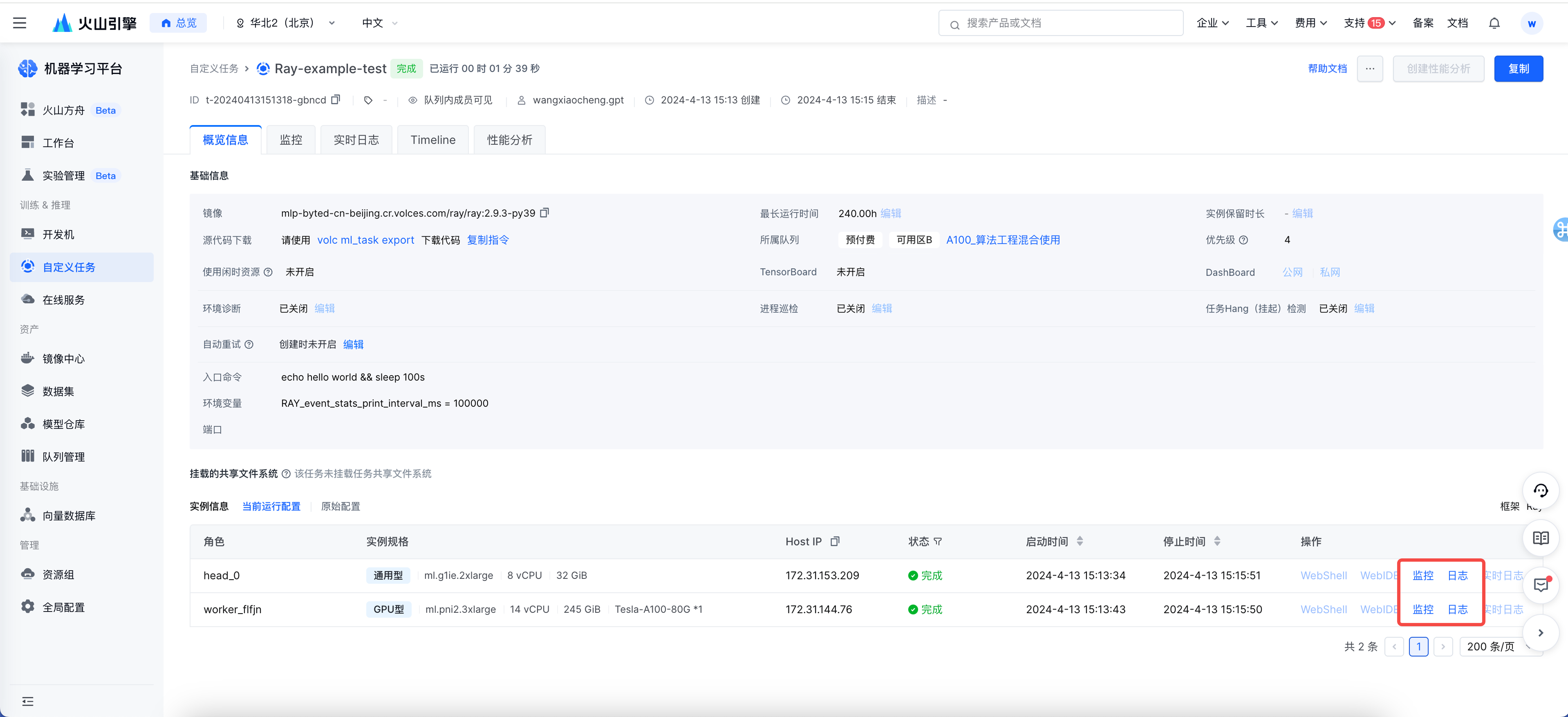

- 创建完成后,您可在控制台查看对应的 Ray 任务,并查看所需要的信息

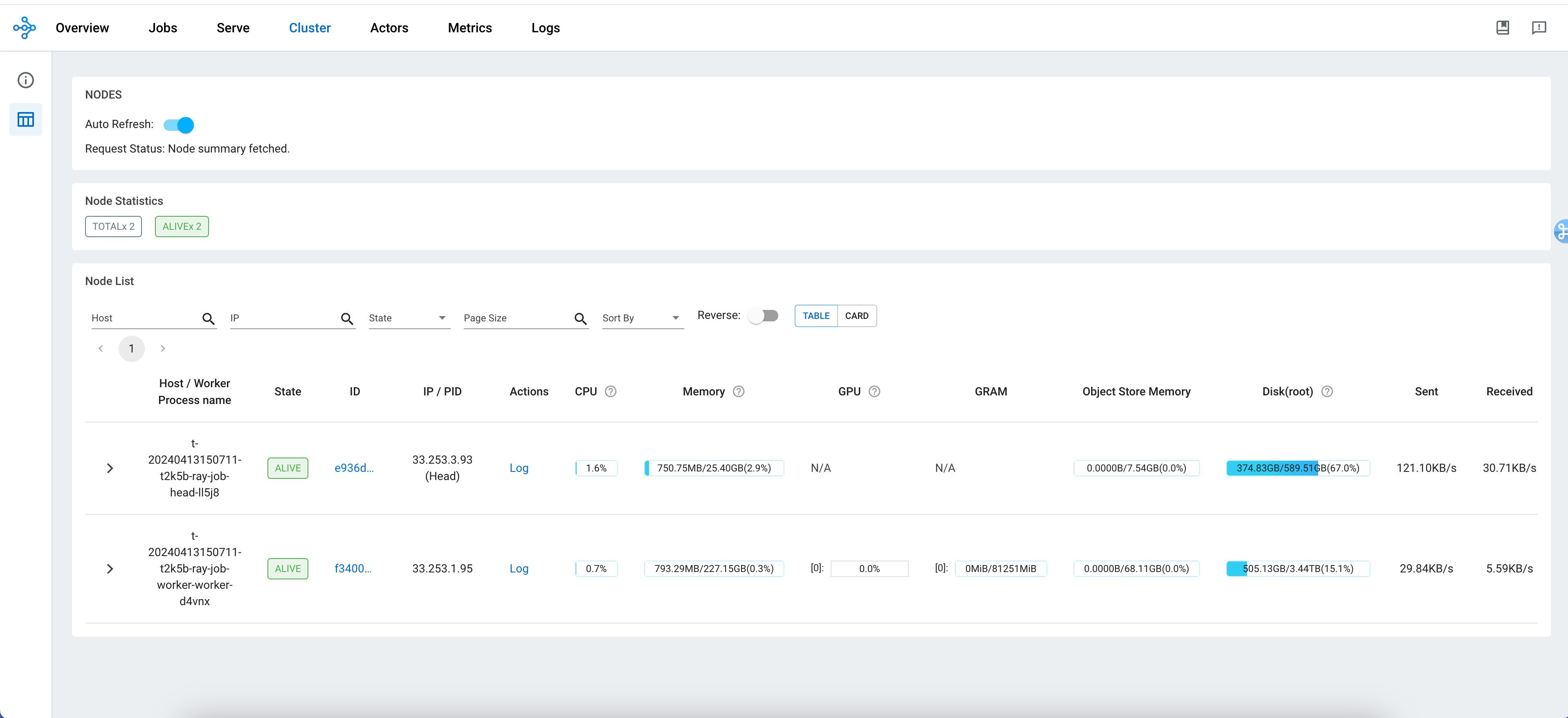

访问 Ray Dashboard

方式一:通过 DashBoard 入口直接访问

进入任务详情页面,基础信息模块提供 Ray DashBoard 公网/私网访问入口。

点击相应「公网」/「私网」,即可根据您的访问需求进入「Dashboard」。

说明

如何选择公网/私网访问: 当任务所属的队列资源组,其配置的VPC在【全局配置】中已开启公网访问,则该任务可以通过公网访问 Ray Dashboard;反之,则仅支持通过私网访问。

方式二:通过 Dashboard 的 port 信息访问

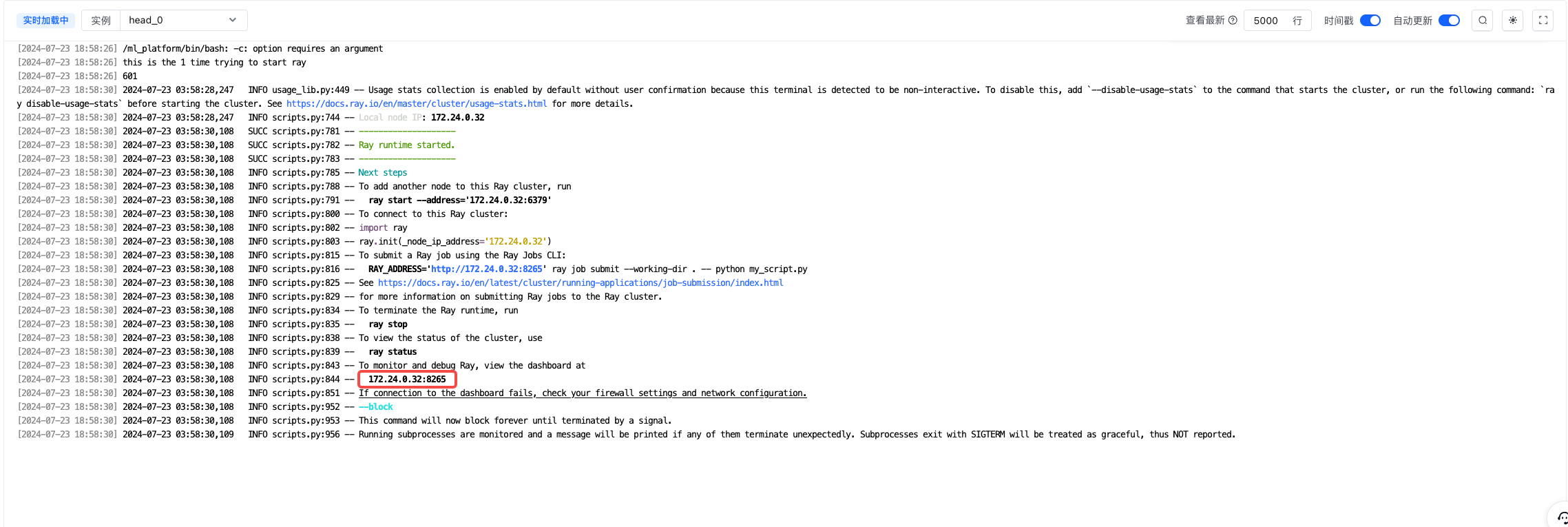

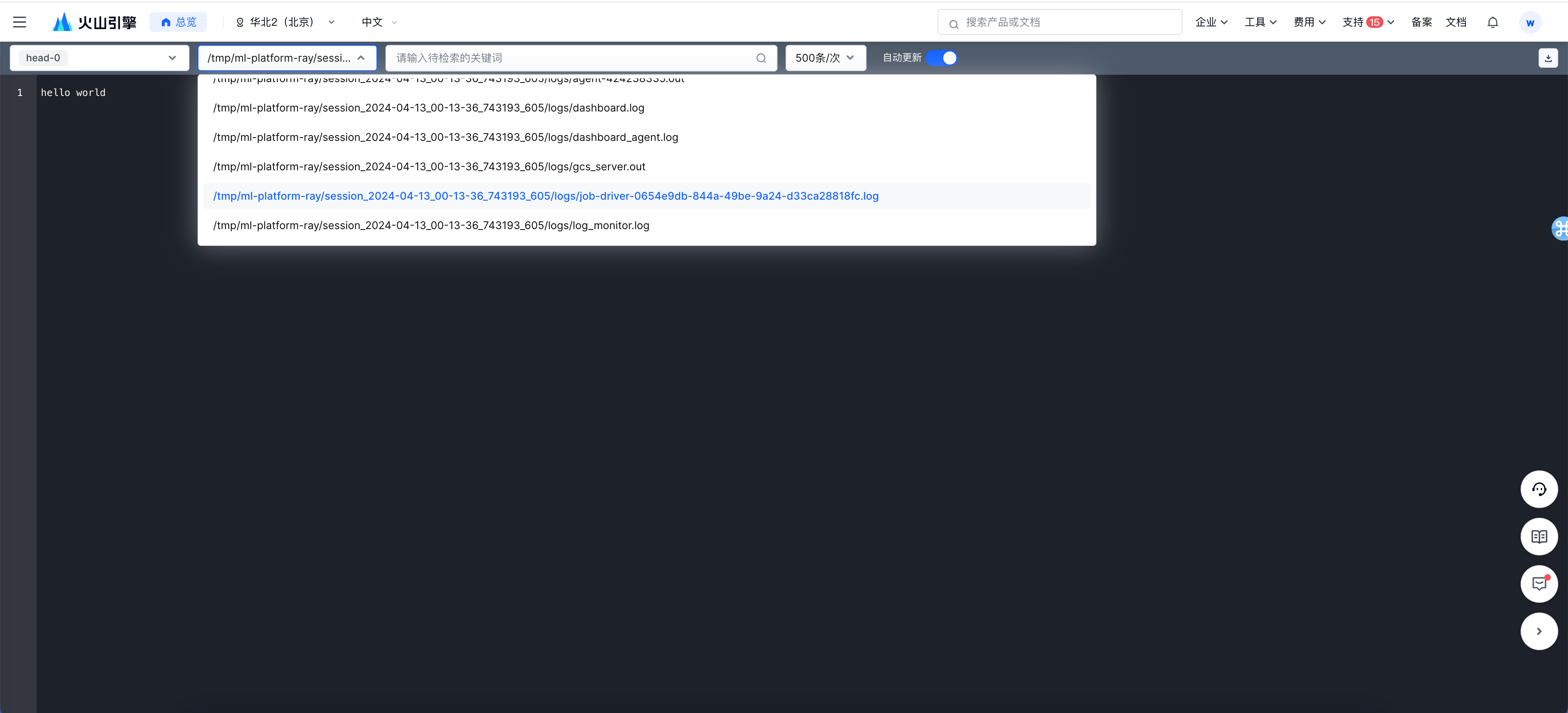

- 在任务详情页面,选择「实时日志」,查看 Ray Dashboard 访问的 port 信息。

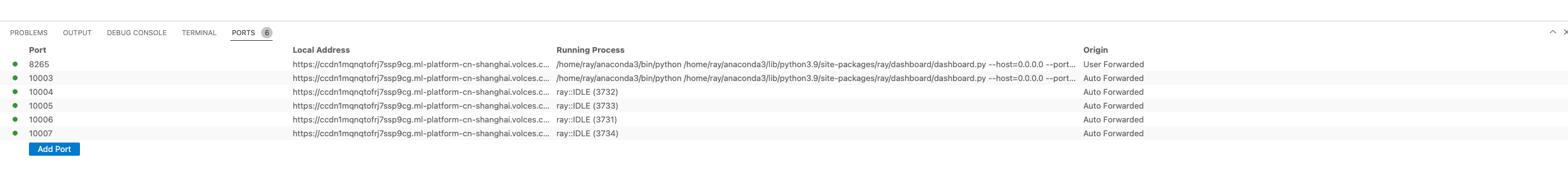

切回「概览信息」页面,选择「Head 实例」,点击「WebIDE」,打开「New Terminal」,切换为「Ports」。

输入刚才在日志页面查看的 port,此处示例为「8265」,点击「Local Address」即可访问「Ray Dashboard」。

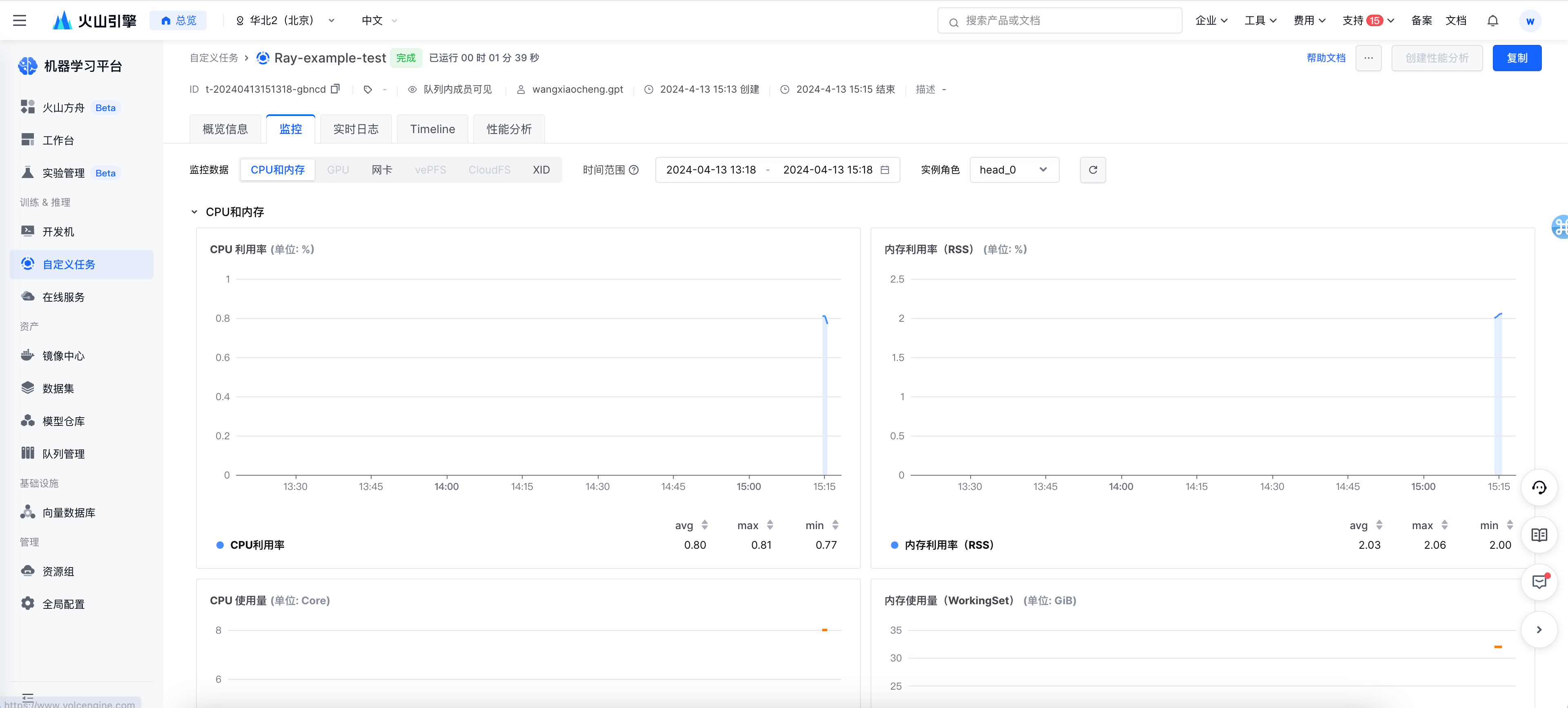

访问日志/监控

- 您可通过平台提供的「日志」入口查看完整日志以及相关监控。您可以基于上一步中的「Ray Dashboard」查看相关日志及监控信息。

容错能力

通过 Ray 创建的 worker 实例具备容错功能。即当 worker 遇到故障失败,也能够在分钟级恢复并重新加入集群。