导航

DeepSeek-V3-0324 创建服务/升级服务说明

最近更新时间:2025.03.28 16:47:18首次发布时间:2025.03.28 16:34:19

说明

xLLM 适用DeepSeek-V3-0324 模型地址:tos://preset-models-cn-beijing/deepseek-ai/DeepSeek-V3-0324-veMLP/。其他 region 替换中间域名(preset-models-xx-xxxx)即可。

新增 DeepSeek-V3-0324 服务

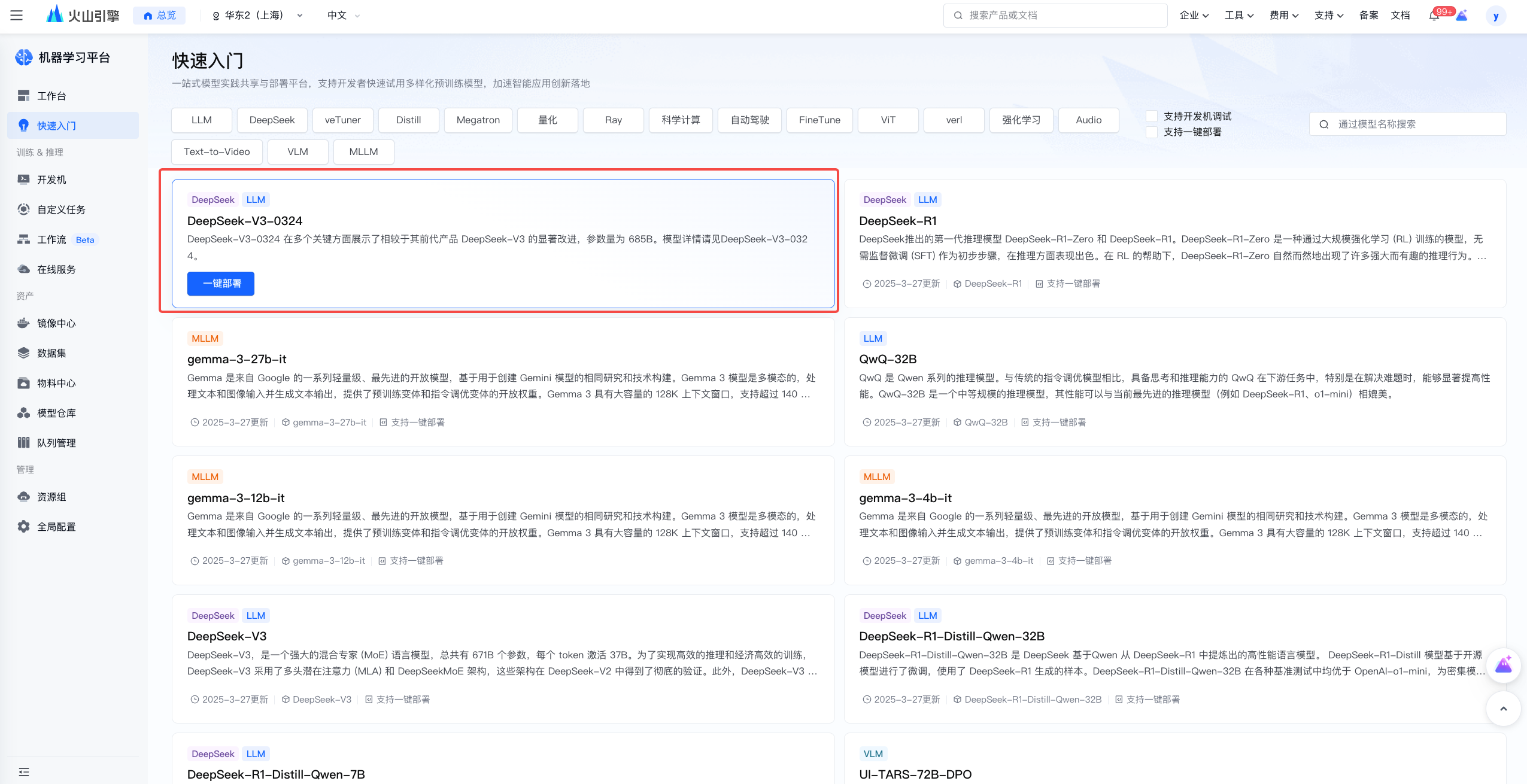

快速入门

在「快速入门」页面,选择模型「DeepSeek-v3-0324」,点击「一键部署」。

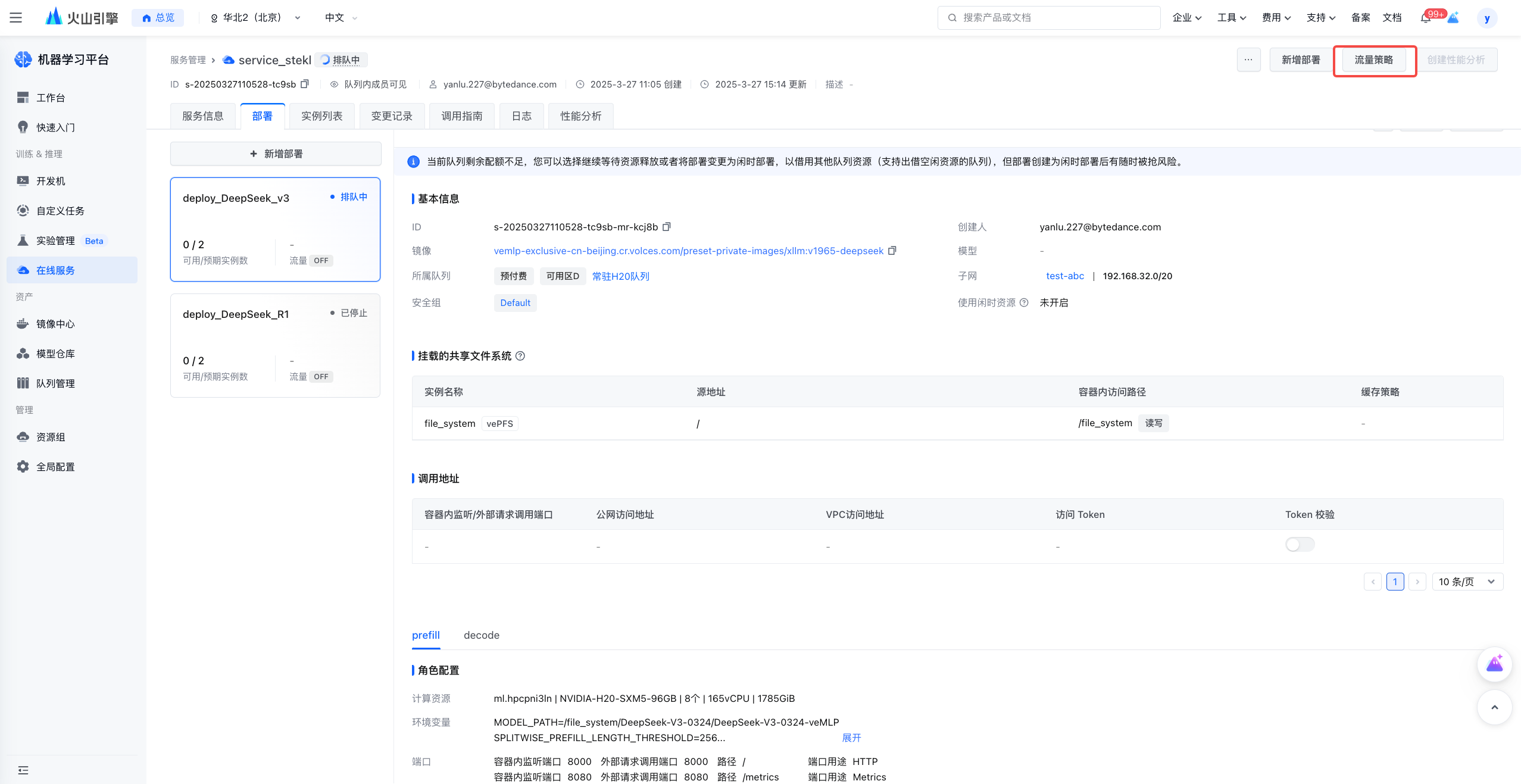

标准部署

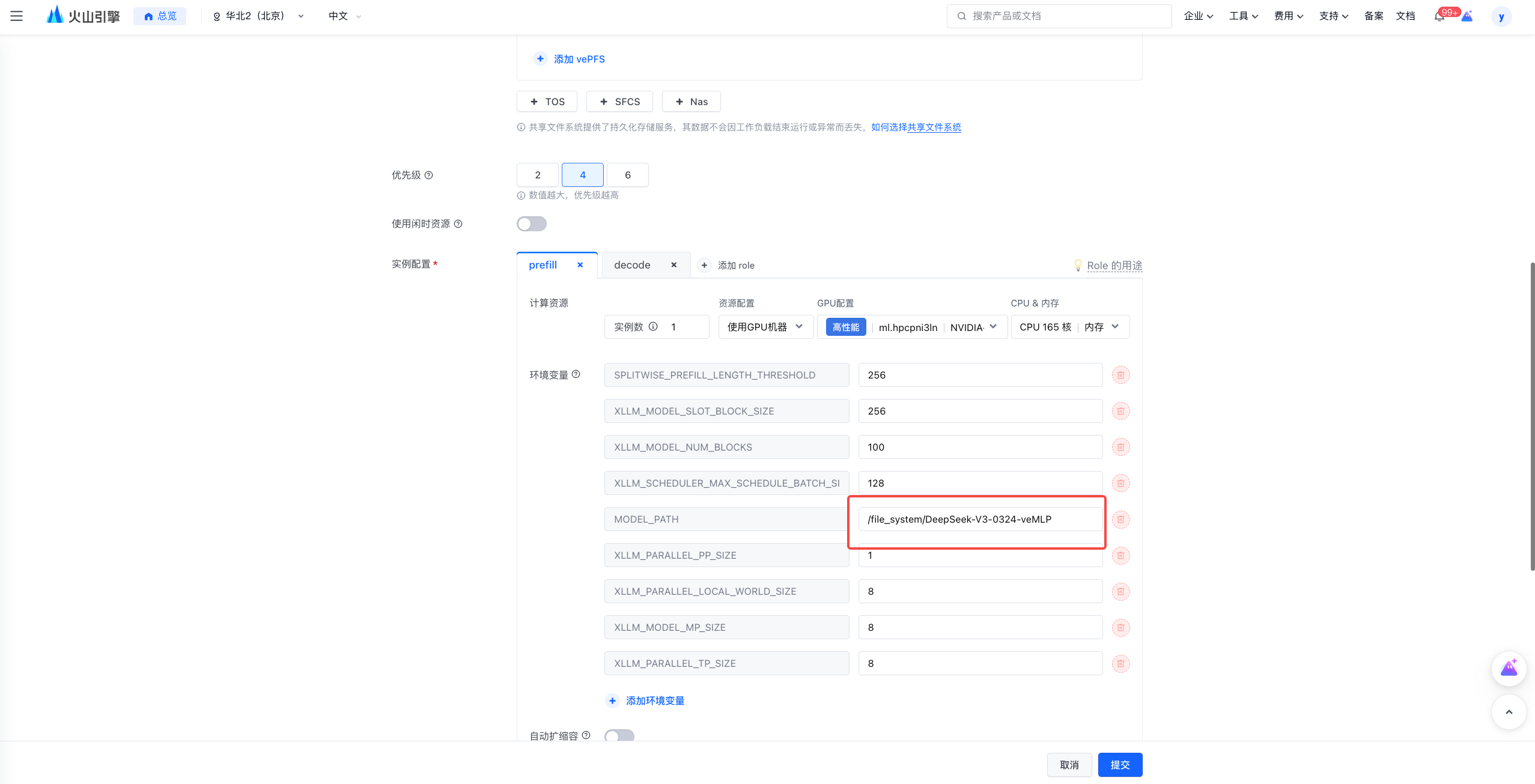

基本操作同 veMLP xLLM 推理引擎PD分离部署DeepSeek R1,最高吞吐提升5倍

差异点如下:

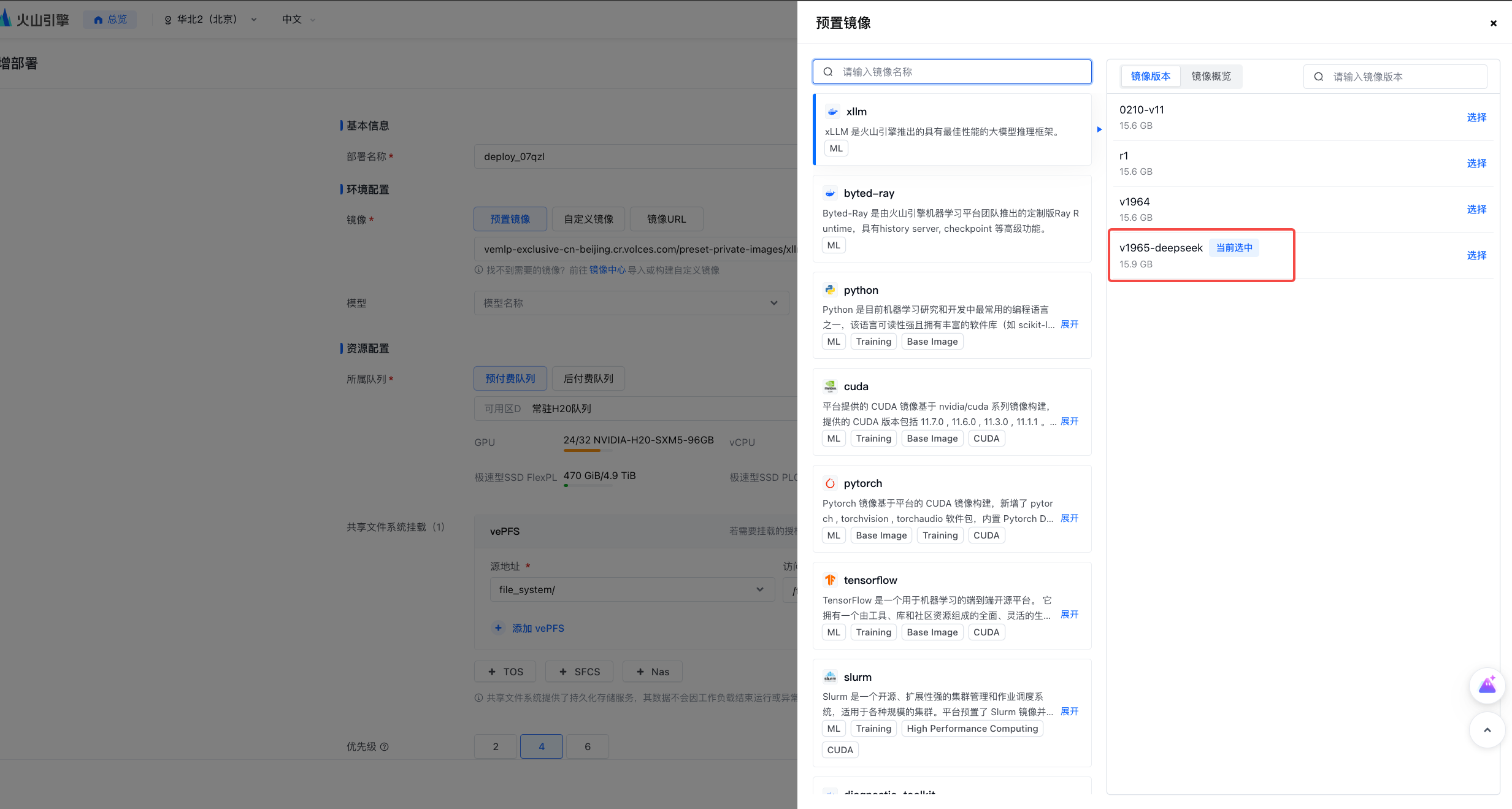

镜像:选择为 xllm : v1965-deepseek

模型:模型路径替换为客户自己下载后的 DeepSeek-v3-0324 的存储路径

升级 DeepSeek-V3-0324 服务

离线升级

若用户可以接受现有 R1 服务暂停运行,则推荐使用离线升级方案。

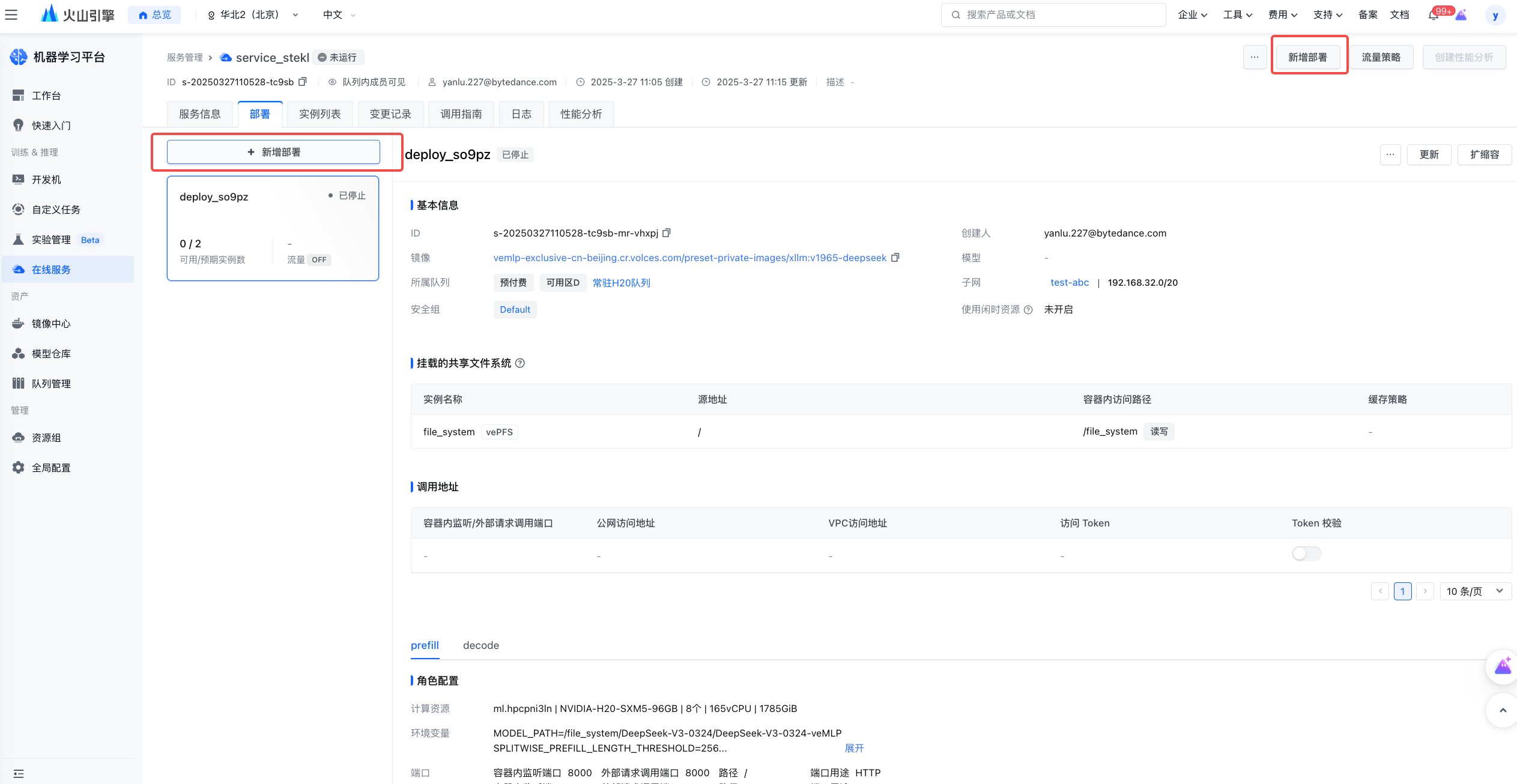

即在原 R1 服务页面,停止旧的R1 部署并且在页面右上角或部署列表左侧选择「新增部署」。

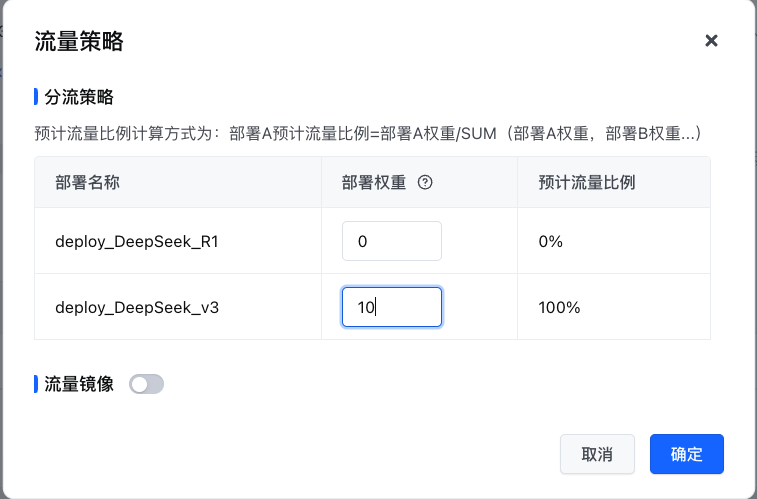

新增部署配置同上 标准部署 操作说明,创建完成且新部署状态为「运行中」时,点击右上角「流量策略」,并且配置 V3的部署权重为10,旧的 R1 部署权重为0,至此服务完成升级。

在线升级

若用户业务不能接受服务中断,需在线业务平滑升级,则请 CSM 或者 L1/L2 同学提人工 oncall,MLP oncall 值班同学将排期帮忙处理。

升级限制说明

说明

由于镜像版本兼容性以及部分已知缺陷,请勿在原 R1 部署直接更新镜像或者模型。

SGLang 模型地址

平台同时支持提供开源推理引擎 SGLang 部署 DeepSeek-V3-0324,模型地址如下:tos://preset-models-cn-beijing/deepseek-ai/DeepSeek-V3-0324。其他 region 替换中间域名(preset-models-xx-xxxx)即可。