本文介绍如何在火山引擎容器服务(VKE)集群中,快速部署 DeepSeek-R1-Distill 模型推理服务,满足您的业务需求。

背景信息

DeepSeek-R1-Distill:基于 DeepSeek-R1 生成的 800K 样本对原开源模型进行微调得到的新模型,旨在以更小参数规模保留 DeepSeek-R1 发现的强大推理能力。

使用说明

下文主要介绍容器服务测试并验证通过的实践内容,为了获得符合预期的结果,同时符合容器服务的 使用限制,请按照本文方案(或在本文推荐的资源上)操作。如需替换方案,您可以联系对应的火山引擎客户经理咨询。

前提条件

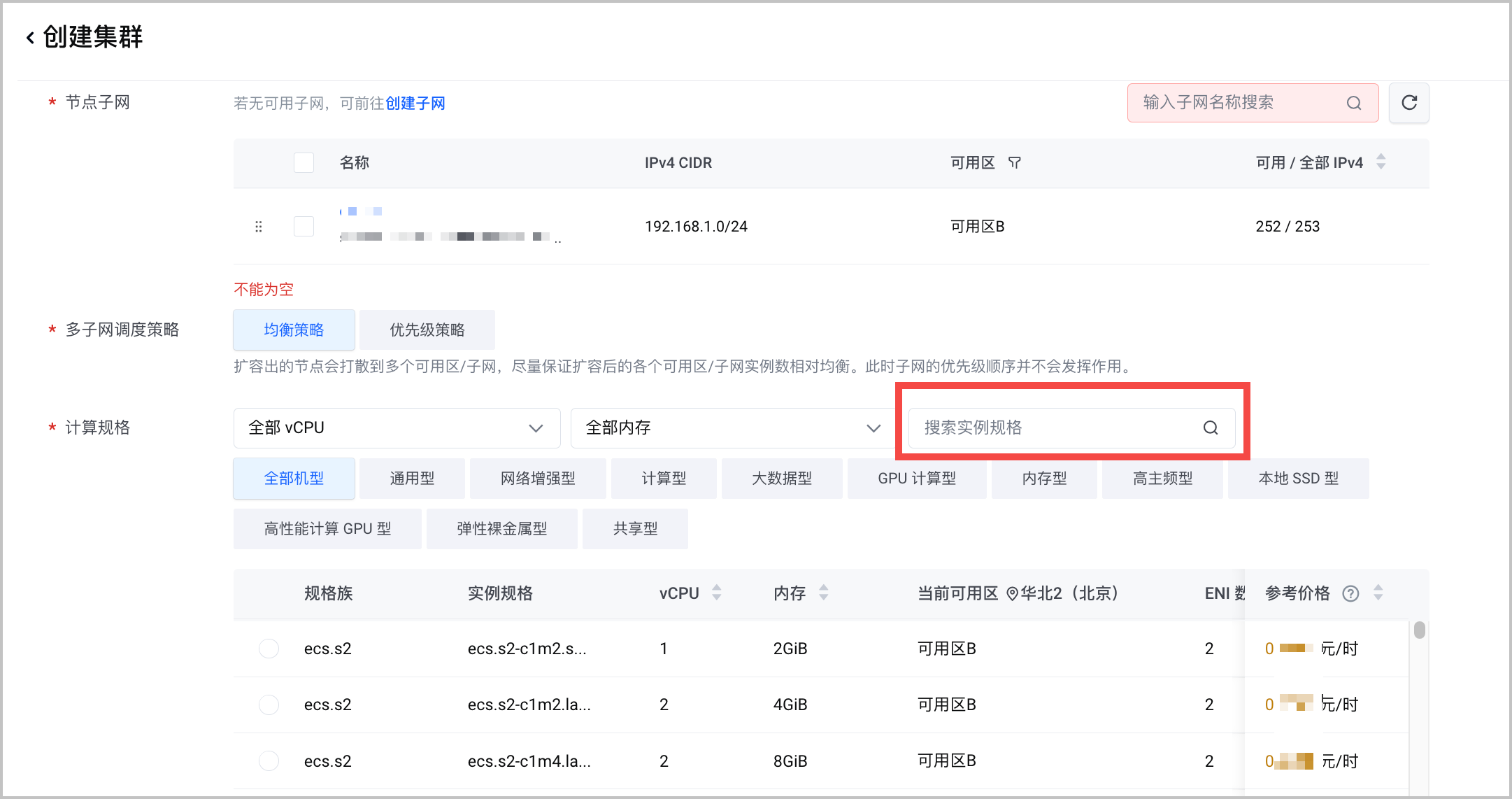

在容器服务中创建集群,需要注意以下列举的参数配置。详细的操作步骤和参数说明,请参见 创建集群。

容器网络模型:选择 VPC-CNI。

计算规格:推荐使用不同的机型部署不同的模型,以发挥最大性价比。以下为常用的蒸馏模型机型配置推荐,供参考。

模型名称 参数量 基础模型 上下文窗口 机型推荐 DeepSeek-R1-Distill-Qwen-7B 7B Qwen2.5-Math-7B 32k ecs.xni3c.5xlarge ecs.gni3cg.5xlarge/ecs.gni3cl.5xlarge DeepSeek-R1-Distill-Qwen-32B 32B Qwen2.5-32B 32k ecs.pni3l.11xlarge(上架中) ecs.gni3cg.22xlarge/ecs.gni3cl.22xlarge ecs.xni3c.22xlarge DeepSeek-R1-Distill-Llama-70B 70B Llama-3.3-70B-Instruct 32k ecs.pni3l.11xlarge(上架中) ecs.pni3l.22xlarge 组件配置:安装 csi-tos 和 nvidia-device-plugin 两个组件。

操作步骤

下文通过火山引擎持续交付(CP)产品,快速部署在 VKE 中创建的 DeepSeek-R1-Distill。

第一步:创建部署集群

将已创建的 VKE 集群接入持续交付平台。

登录 持续交付控制台。

在左侧导航栏选择 资源管理。

在资源管理页面,切换至 部署资源 页签。

在 部署资源 页签,单击 创建部署资源 。

在 创建部署资源 对话框,按界面提示配置部署资源信息。重点注意以下参数配置,其他参数说明请参见 接入 VKE 集群。

配置项 说明 接入类型 选择 容器服务 VKE。 地域 选择已创建容器服务集群所在的地域。 共享范围 选择 所有工作区。

第二步:创建 AI 应用

说明

【邀测·申请试用】AI 应用在持续交付产品侧处于邀测阶段。如需体验,请联系您的售前经理或解决方案经理。

在持续交付的 AI 应用 模块,部署大模型应用。

- 登录 持续交付控制台。

- 在左侧导航栏选择 AI 应用。

- 在 AI 应用页面,单击 创建应用。

- 选择 自定义创建 模板,并单击 下一步:应用配置。

- 按界面提示填写应用的相关配置信息。配置完成后单击 确定,应用将开始创建并部署。重点注意以下参数配置,其他参数说明请参见 创建和部署 AI 应用(自定义创建)。

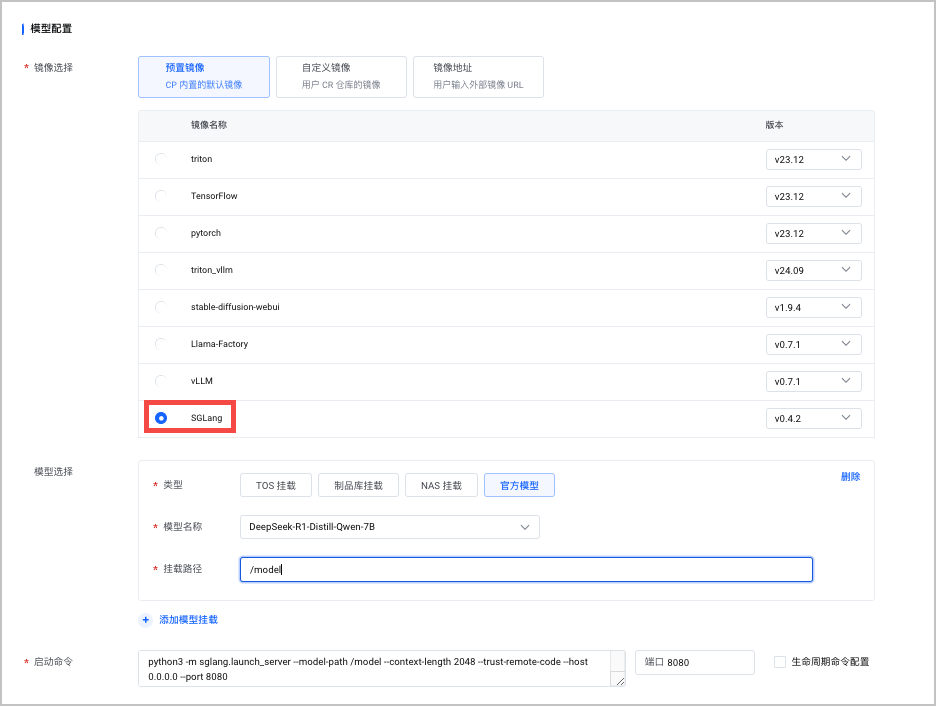

部署集群

配置项 说明 部署资源 选择已创建的容器服务集群。 模型配置

配置项 说明 镜像选择 选择 预置镜像 > SGLang。 模型选择 选择 官网模型 类型中选择 DeepSeek-R1-Distill 的相关模型。 挂载路径 为 /model。启动命令 默认配置启动命名。请根据实际推理服务的需要,修改默认启动命令。 推理服务规格

配置项 说明 实例数 选择 1。 弹性容器实例 本示例不选择该功能。 资源配置类型 根据不同的 DeepSeek-R1-Distill 模型,参考下表选择相应配置。 模型名称 CPU 请求/上限 内存请求/上限 DeepSeek-R1-Distill-Qwen-1.5B 12Core 60GiB DeepSeek-R1-Distill-Qwen-7B 14Core 60GiB DeepSeek-R1-Distill-Qwen-32B 20Core 110GiB DeepSeek-R1-Distill-Llama-70B 40Core 220GiB

第三步:创建负载均衡

部署完成后,创建负载均衡以支持应用在私网和公网中的访问。创建完成后支持通过负载均衡 IP 地址调用大模型。

登录当前应用。

- 登录 持续交付控制台。

- 在左侧导航栏选择 AI 应用。

- 在 AI 应用页面,选择目标 AI 应用,单击应用卡片,进入当前应用的基本信息页签。

在 基本信息 > 访问设置 页签,配置应用的访问方式。详情操作说明参见 访问设置。

- 容器端口 和之前应用的端口保持一致。

- 在创建负载均衡时,私有网络 配置必须与之前创建 VKE 集群使用的私有网络相同。

- 容器端口 和之前应用的端口保持一致。

操作结果

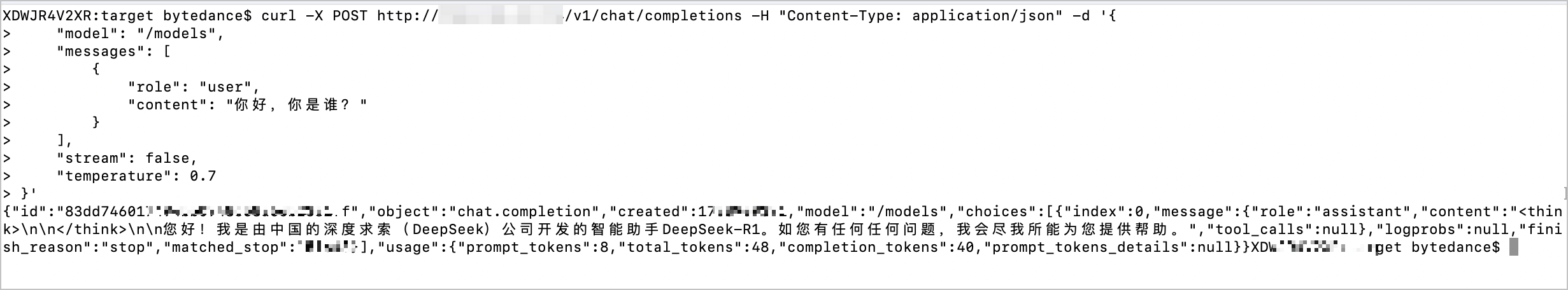

通过本地 curl 命令和已创建的负载均衡 IP 调用大模型 API,即可成功与 DeepSeek-R1-Distill 模型对话。

curl -X POST http://xxxx/v1/chat/completions -H "Content-Type: application/json" -d '{ "model": "/model", "messages": [ { "role": "user", "content": "你好,你是谁?" } ], "stream": false, "temperature": 0.7 }'