DataLeap 数据开发即大数据开发 IDE,集批流开发为一体,为开发者提供高效、智能的开发环境。支持快速创建与 火山引擎 E-MapReduce(EMR)、流式计算 Flink 版、ByteHouse 企业版/云数仓版、EMR Serverless Spark 等计算引擎相关的开发任务、进行代码编辑开发、运行查询等。

本文将向您介绍如何在 DataLeap 数据开发平台上进行数据的计算、分析和加工等操作,以完成简单的数据开发场景。

1 使用前提

- EMR 引擎相关数据开发任务,您需先在 DataLeap 租户控制台中,完成 EMR 引擎绑定操作。详见引擎绑定。

- 已开通 DataLeap 对应服务版本,并创建 DataLeap 项目,且需在项目控制台中绑定相关计算引擎。详见创建项目。

- 已创建相应计算引擎下的数据库元数据采集器。详见元数据采集。

2 新建数据开发任务

数据采集执行完成,将数据同步至目标数据源后,便可开始进行相应数据源的数据开发任务创建,进行数据的加工、分析等操作。

新建任务操作如下:

- 登录 DataLeap租户控制台。

- 在概览界面,显示加入的项目中,单击数据开发进入对应项目。

- 在任务开发界面,左侧导航栏中,单击新建任务按钮,进入新建任务页面。

- 在新建任务界面,选择任务类型:

- 分类:数据开发。

- 绑定引擎:选择当前项目在项目控制台中已绑定的计算引擎类型。

- 关联实例:显示项目绑定时的集群实例信息。

- 选择任务:按需选择离线数据、流式数据下的任务类型。

- 填写任务基本信息:

- 任务名称:输入任务的名称,只允许字符.、字母、数字、下划线、连字符、[]、【】、()、()以及中文字符,且需要在 127 个字符以内。

- 保存至:选择任务存放的目标文件夹目录。

- 单击确定按钮,成功创建任务。

3 配置数据开发任务

3.1 任务编辑

新建任务完成后,进入可视化任务配置界面,进行相应计算引擎的 SQL 代码编辑、Pyspark 脚本编辑、Java 类型作业开发等。

当前已支持的数据开发类型及配置操作详见 数据开发类型说明。

3.2 调度设置

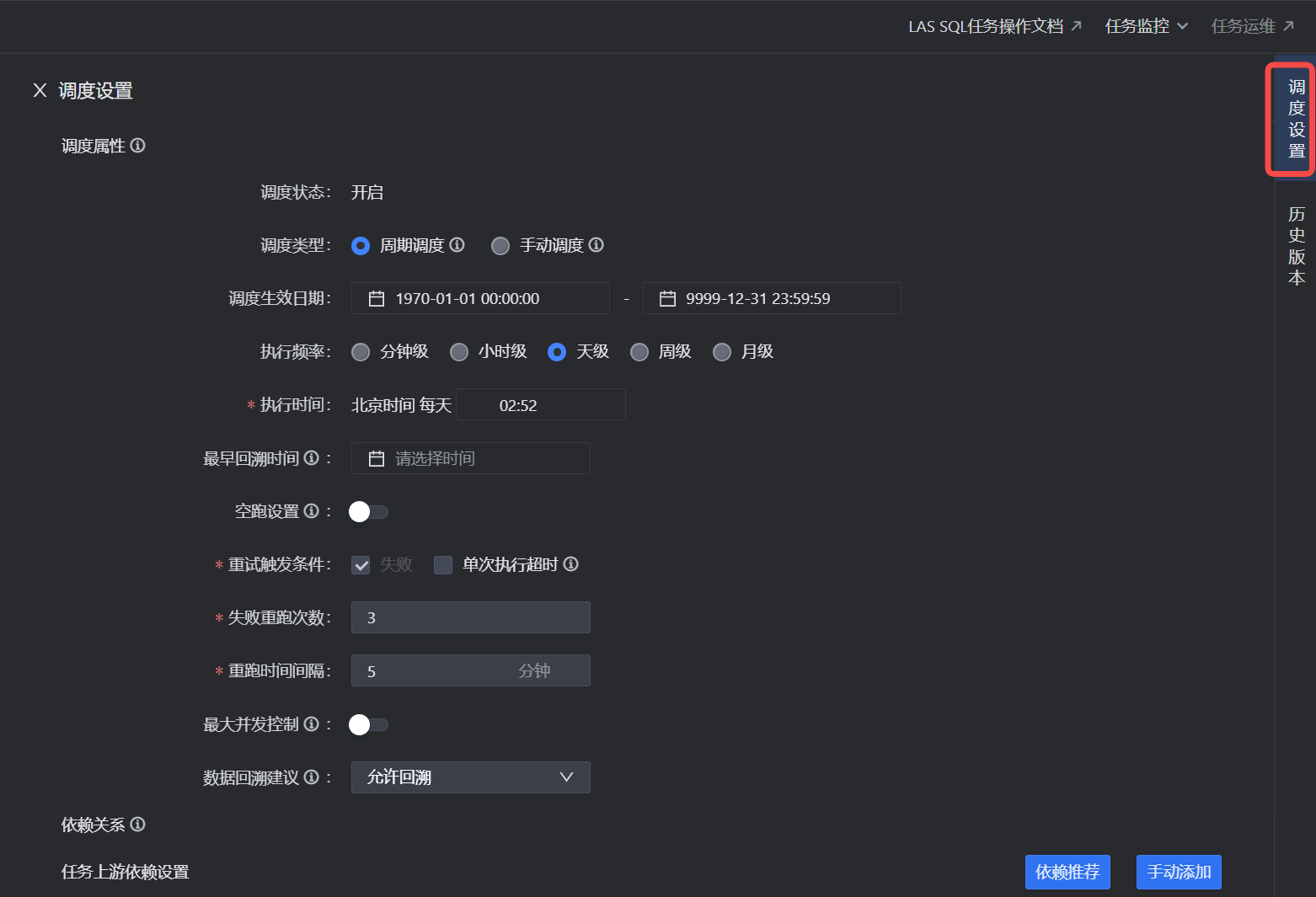

离线任务完成代码编辑后,您需要为离线任务设置调度运行时的相关属性。如调度时间、调度依赖、上下文传参等参数配置。详见调度设置。

说明

流式任务无需进行调度参数设置。

3.3 参数设置

流式任务完成代码编辑后,您需要为其设置流式作业运行资源、Flink 运行参数、数据源登记等参数信息。流式任务参数设置操作详见 Serverless Flink SQL 参数设置。

3.4 提交上线

任务编辑保存完成后,单击操作栏中的提交上线按钮,在弹窗中,完成以下提交上线内容配置后,单击确认按钮,完成作业提交。

离线任务、流式任务提交上线操作不同,操作详见 提交上线 说明。

4 发布中心

发布中心模块,主要目标是提高数据研发效率,规范任务发布流程,区分开发-生产环境,提高生产安全及稳定性,完善数仓研发全链路能力建设。

数据开发类型的任务提交上线时,若在提交过程中只选择仅提交,则您需进入发布中心,在此进行待发布和发布包管理等操作。

5 运维中心

任务提交发布成功后,可进入运维中心查看任务运维。在上方导航栏中,进入离线任务运维、实时任务运维。您可在运维中,按需查看任务运行情况,可对任务进行监控报警设置、开启任务、停止任务、查看运行日志等运维操作。

更多操作详见:离线任务运维、流式任务运维。

6 临时查询

临时查询支持各计算引擎 SQL、Notebook 任务类型的创建、运行及结果数据预览,您可便捷地在数据开发过程中测试代码的实际运行情况与期望是否相符、排查代码错误等。

说明

临时查询不需要将任务提交上线和设置调度参数。如果您需要使用周期性调度任务,请在数据开发页面中新建任务。详见3 配置数据开发任务。

更多临时查询相关操作,详见临时查询。