DataLeap Python 任务可根据您实际业务场景,在任务中按需使用第三方依赖包,以满足复杂的业务场景。

本文将为您介绍 Python 任务如何使用第三方依赖包。

1 使用前提

已开通 DataLeap 服务。

2 新建 Python 任务

- 登录 DataLeap租户控制台,并进入项目的 IDE 开发界面,进行新建任务操作。

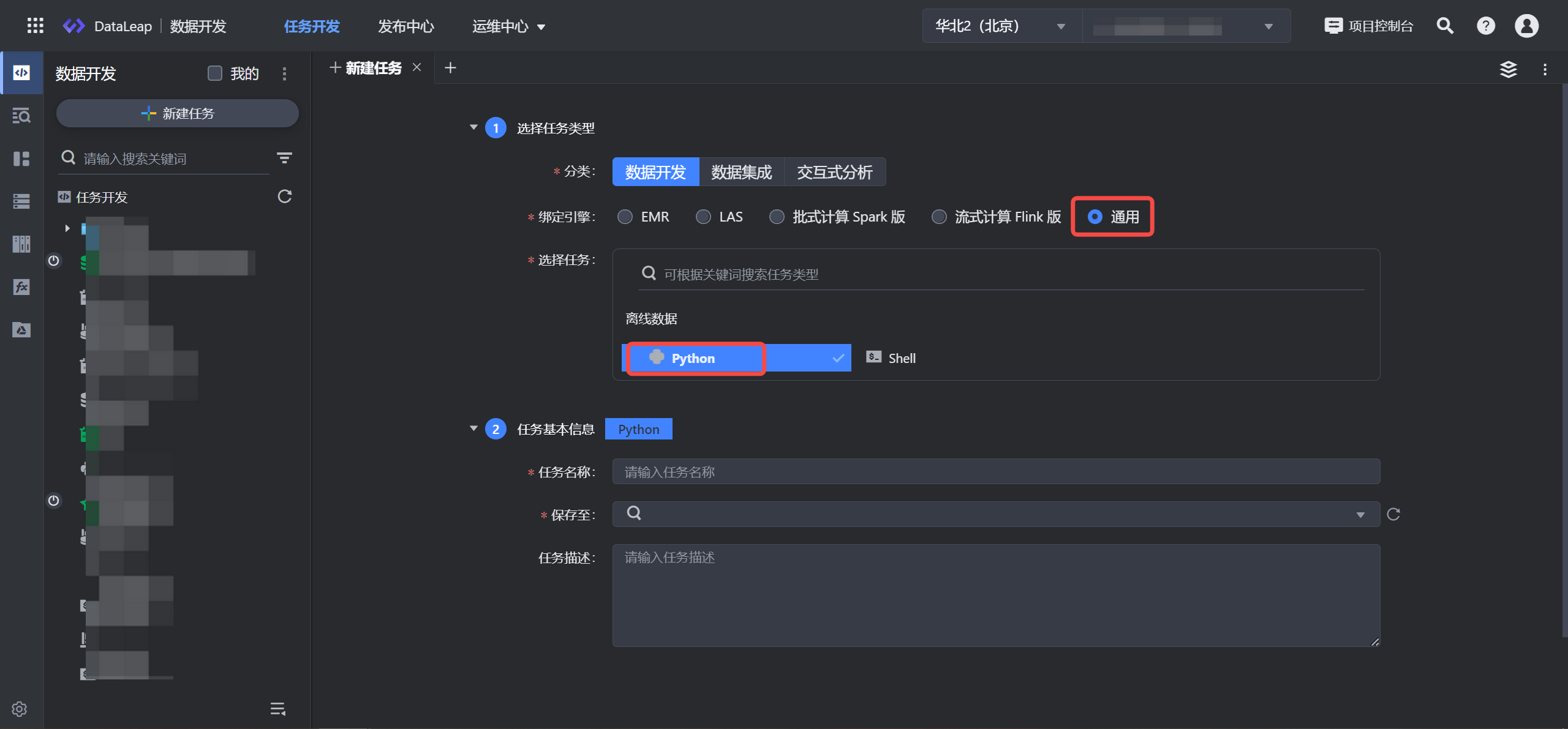

- 单击新建任务按钮,并依次选择数据开发 > 通用 > Python 任务类型。

- 填写任务基本信息,输入任务名称信息,如:python_task,并选择任务存放的目标文件夹目录。单击确定按钮,完成任务创建。

注意

任务名称信息仅允许字符.、字母、数字、下划线、连字符、[]、【】、()、()以及中文字符,且需要在127个字符以内。

3 第三方依赖包安装

Python 任务创建完成后,便可通过 Python 任务安装第三方依赖包。下方为您介绍几种安装方式,您可根据实际情况进行操作。

注意

- 如果您的业务场景对任务稳定性要求高,建议采用3.1 方式一:本地上传依赖包(推荐)。

- 3.2 方式二:资源设置添加依赖包此方式依赖火山引擎的资源,在火山引擎资源维护期间,可能会偶发安装失败的情况进而导致调度任务失败。

- 在通过3.3 方式三:外网形式访问,使用外部第三方 PyPI 源时,可能因 PyPI 源不可用而导致任务失败,请谨慎使用!在对任务稳定性要求高的场景中,建议采用3.1 方式一:本地上传依赖包(推荐)。

3.1 方式一:本地上传依赖包(推荐)

当前资源无法访问外网时,您可以通过上传本地的依赖资源包,并通过 Python 任务引用的方式,来实现使用第三方依赖包的场景。

3.1.1 下载依赖包到本地

您可在有 Python 环境的客户端或 PyCharm 等工具中,下载任务所需的依赖包。此示例中以 HDFS 依赖包为例:

注意

依赖包需在 Linux 系统的 Python 3.7 或 Python 3.12 环境中下载,且只有当 Python 任务选择的执行引擎版本,与依赖包下载时的版本环境一致时,该依赖包才能在 Python 任务中正常引用执行。

通过 pip download 命令生成所需的依赖包:

mkdir hdfs pip download hdfs -d hdfs将下载下来的包压缩并上传:

zip -r hdfs.zip hdfs

3.1.2 上传资源

在 DataLeap 平台中上传 hdfs.zip 压缩包:

- 登录DataLeap租户控制台。

- 在概览界面,显示加入的项目中,单击数据开发进入对应项目。

- 在左侧导航栏单击资源库进入。

- 在资源库界面,下拉选择通用资源类型(上方图中第”2“步),然后通过两个新建资源入口(上方图中第”3“步),进行通用资源类型创建。

- 在资源创建界面,依次完成资源关联信息和基本信息配置,其中在 基本信息 > 资源文件处,单击”点击上传“按钮,将本地准备好的资源包上传到平台。

- 单击确定按钮,便可完成资源上传。

更多资源上传操作详见资源库。

3.1.3 Python 任务中使用依赖包

打开 Python 任务编辑界面;

在编辑界面右侧单击执行设置窗口进入,并进行资源选择;

在执行设置窗口中,下拉资源选择栏,勾选已添加的依赖包文件,并完成其余计算资源组、资源配置等信息。

更多执行设置详见3.2.5 执行设置。资源选择完成后,便可在 Python 编辑界面,进行相应任务开发,示例如下:

注意

Python 任务在脚本中访问公网或指定私有网络(VPC)访问时,您需通过下方的网络配置(可选),选择能与您资源互通的私有网络、子网、安全组信息。

亦或是您也可通过使用独享计算资源组来实现网络互通,可将独享计算资源组所在的 VPC 开通公网,或是和您资源所在的 VPC 通过 CEN 做网络打通工作。import os #安装上传资源包中 hdfs 目录下的依赖包信息: os.listdir('.') os.system('pip install --no-index --find-links=hdfs hdfs') #使用安装好的第三方依赖包: from hdfs import InsecureClient from docopt import docopt #验证 docpot 的能力 doc = """ Usage: test.py [--name=<name>] Options: --name=<name> Name to print [default: World]. """ # 模拟命令行参数 arguments = docopt(doc, argv=['--name=HDFS']) print(f"Hello, {arguments['--name']}!") # 验证 hdfs 的能力 # 假设有一个 HDFS 服务正在运行,替换为你的 HDFS 地址 hdfs_url = 'http://localhost:50070' # HDFS 的地址 client = InsecureClient(hdfs_url, user='your-username') # 替换为你的用户名 # 测试列出 HDFS 根目录 try: print("Listing HDFS root directory...") files = client.list('/') print("Files in HDFS root directory:", files) except Exception as e: print("Failed to connect to HDFS:", e)测试脚本编辑完成后,依次单击编辑器上方的保存、调试按钮,等待脚本执行完成。

脚本执行完成后,可在下方日志信息中,查看最终的执行结果。

3.2 方式二:资源设置添加依赖包

在任务配置 - 资源配置栏中,手动输入第三方依赖包名称信息,并指定依赖包具体版本,如按照 “numpy==1.21.6” 格式添加,支持添加多个第三方依赖包,用英文分号分隔。

注意

- 此方式依赖火山引擎的资源,在火山引擎资源维护期间,可能会偶发安装失败的情况进而导致调度任务失败。 对于任务稳定性要求极高的场景,建议采用3.1 方式一:本地上传依赖包(推荐)。

- 配置依赖包时建议加上对应包的版本,以保证每次运行环境一致。

- 代码中没有依赖的包,不建议添加配置。

3.3 方式三:外网形式访问

注意

使用外部第三方 PyPI 源时,可能因 PyPI 源不可用而导致任务失败,请谨慎使用!在对任务稳定性要求高的场景中,建议采用3.1 方式一:本地上传依赖包(推荐)。

当前资源可通过外网形式访问时,可指定外网 pip 源来安装,可在 Python 任务中,执行以下脚本:

import os os.system('pip install numpy(替换所需的第三方包名称) -i https://pypi.tuna.tsinghua.edu.cn/simple') os.system('pip list')

上述示例执行后,您便可在下方执行日志中,查看当前环境中安装的所有包信息。