E-MapReduce

E-MapReduce

E-MapReduce

文档指南

请输入

产品动态与公告

产品动态

EMR 软件栈发行版本

版本说明(历史版本)

EMR on ECS-3.17.0及之前版本

EMR 3.x版本

EMR-3.6.X 版本说明

EMR-3.4.X 版本

EMR 2.x版本

EMR 1.x版本

EMR 1.3.x版本

产品简介

产品计费

快速入门

EMR on ECS 快速入门

EMR on VKE 快速入门

EMR on ECS 操作指南

集群管理

集群配置

集群监控

EMR on VKE 操作指南

EMR Serverless 队列操作指南

配置与管理队列

提交作业

元数据管理

Serverless Spark 作业

mGPU 作业

开发指南

EMR Serverless 实例操作指南(OLAP)

权限管理

数据湖查询(StarRocks)

性能调优

组件操作指南

Celeborn

DolphinScheduler

DolphinScheduler 对接 EMR Serverless

HBase

Hive

Iceberg

Knox

Lance

Livy

MapReduce2

OpenLDAP

Phoenix

Proton

基础使用

高阶使用

Ranger

Ray

RayCluster 使用

Spark

StarRocks

数据湖分析

最佳实践

Tez

YARN

最佳实践

EMR on ECS 最佳实践

EMR on VKE最佳实践

EMR Serverless 实例最佳实践

StarRocks

Doris

EMR Serverless 队列最佳实践

Spark

开发参考

API 参考

EMR on ECS API参考

集群管理

节点组管理

用户管理

用户组管理

应用管理

EMR on VKE API参考

SDK 参考

EMR on ECS SDK 参考

EMR Serverless SDK 参考

常见问题

- 文档首页

元数据迁移

迁移和部署 Apache Hive 到火山引擎 EMR #

Apache Hive 是一个开源的数据仓库和分析包,它运行在 Apache Hadoop 集群之上。Hive 元存储库包含对表的描述和构成其基础的基础数据,包括分区名称和数据类型。Hive 是可以在火山引擎 E-MapReduce(简称“EMR”)上运行的服务组件之一。

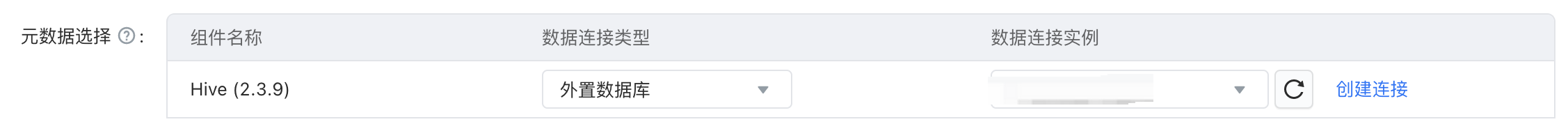

火山引擎 EMR 集群的 Hive 元数据可以选择内置数据库和外置数据库。

- 内置数据库作为 Hive 元数据建议只应用于开发和测试环境。

- 使用火山引擎 RDS 作为 Hive 元数据

外置数据库可以是火山引擎的 RDS 数据库或者客户在 ECS 上部署的数据库实例。

创建集群时,可以选择外置数据库作为 Hive 元数据。外置数据库可以是客户购买的火山引擎 RDS 实例。

Hive 元数据迁移 #

如果元数据更新不频繁,可以使用 beeline 或 Mysql dump 完成 hive metastore 的数据迁移

- 使用 beeline 进行元数据迁移

使用 beeline 获取源 Hadoop 集群建表语句,并在 EMR Hadoop 集群执行。

beeline -u "jdbc:hive2://emr-master-1:10000" -n hive -p <password> -e "show create table test;"- 使用 mysqldump 进行元数据迁移

使用 mysqldump 导出源端元数据,并在 EMR Hadoop 集群导入。

#源端 Hadoop 集群导出数据 mysqldump -uhive -ppassword --no-create-info --databases hive >/tmp/hive-meta.sql #目标 EMR 集群导入数据 mysql -uhive -ppassword -Dhive < hive-meta.sql- 使用 beeline 进行元数据迁移

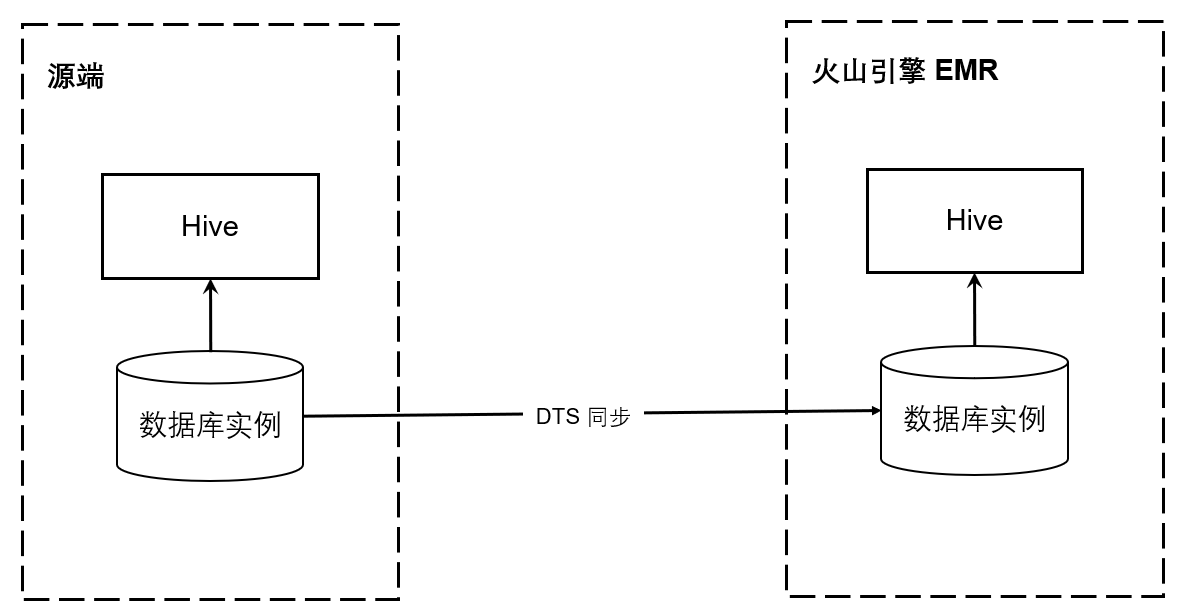

如果元数据更新频繁,可以使用数据库传输服务搭建数据复制链路。

火山引擎数据库传输服务(DTS)支持不同数据库实例之间的数据同步,对于频繁更新的元数据,源端的修改会实时的同步到目标端。

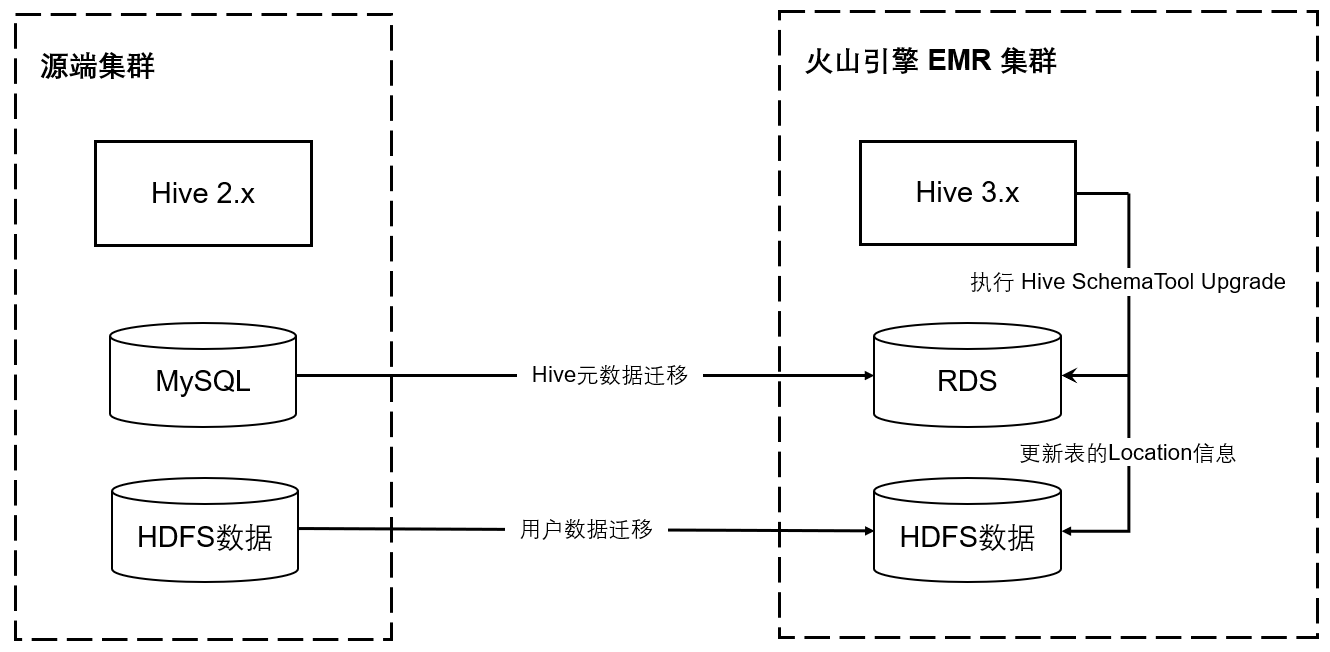

Hive 2.x 迁移至 Hive 3.x #

Hive 3 和 Hive 2 相比,增加了许多新特性(Hive 3.0 Release)。您如果想要使用 Hive 3.x 或者 Spark 3.x、 Hadoop 3.x 需要先将Hive 2.x 升级至 Hive 3.x。您可以使用 Hive SchemaTool 将 Hive 2.x 迁移至 Hive 3.x 版本。 SchemaTool的使用参考。

迁移前需要做好 Hive 元数据的备份,确认 Database、Table 数量,用于迁移后的校验。hive --service schemaTool -upgradeSchema操作期间要求停止 Hive 服务,执行后通过hive —service metatool -updateLocation <new-loc> <old-loc> 更新 Hive 表的 Location 地址。

最近更新时间:2025.01.07 16:19:44

这个页面对您有帮助吗?

有用

有用

无用

无用