导航

E-MapReduce

搜索目录或文档标题搜索目录或文档标题

产品动态与公告

产品简介

发行版本

EMR on ECS

发行版本

版本说明

EMR 3.x版本

EMR-3.6.X 版本说明

EMR-3.4.X 版本

EMR 2.x版本

EMR 1.x版本

EMR 1.3.x版本

产品计费

快速入门

EMR on ECS 操作指南

集群管理

集群配置

集群监控

EMR on VKE 操作指南

EMR Serverless 操作指南

EMR Serverless 队列

EMR Serverless 实例(OLAP)

操作指南

数据湖查询(StarRocks)

性能调优

组件操作指南

MapReduce2

Hive

Spark

Spark(仅适用于EMR on VKE形态)

Spark(仅适用于EMR Serverless Spark形态)

Presto(仅适用于Serverless形态)

Knox

OpenLDAP

Ranger

HBase

Phoenix

Tez

Iceberg

StarRocks

数据湖分析

最佳实践

Proton

基础使用

高阶使用

Livy

Celeborn

Celeborn(仅适用于EMR on VKE形态)

Ray(仅适用于EMR on VKE及EMR Serverless形态)

Raycluster使用

最佳实践

EMR on ECS最佳实践

EMR on VKE最佳实践

开发参考

API 参考

EMR on ECS API参考

集群管理

节点组管理

用户管理

用户组管理

应用管理

EMR on VKE API参考

集群管理

应用管理

EMR Serverless API参考

SDK 参考

EMR on ECS SDK 参考

EMR Serverless SDK 参考

- 文档首页 /E-MapReduce/组件操作指南/Ranger/组件集成/Spark集成

Spark集成

最近更新时间:2024.09.13 11:34:49首次发布时间:2021.09.01 17:27:34

我的收藏

有用

有用

无用

无用

文档反馈

在 Ranger 中,Spark 和 Hive 共用一套 policy 都是 HADOOP SQL -> default_hive,所以具体的配置可以直接参考 Hive集成。

1 使用前提

- 已创建 E-MapReduce(EMR)包含 Ranger 服务的集群,操作详见:创建集群。

- Ranger UI 的登录界面操作,详见:Ranger 概述---Ranger Admin UI 访问。

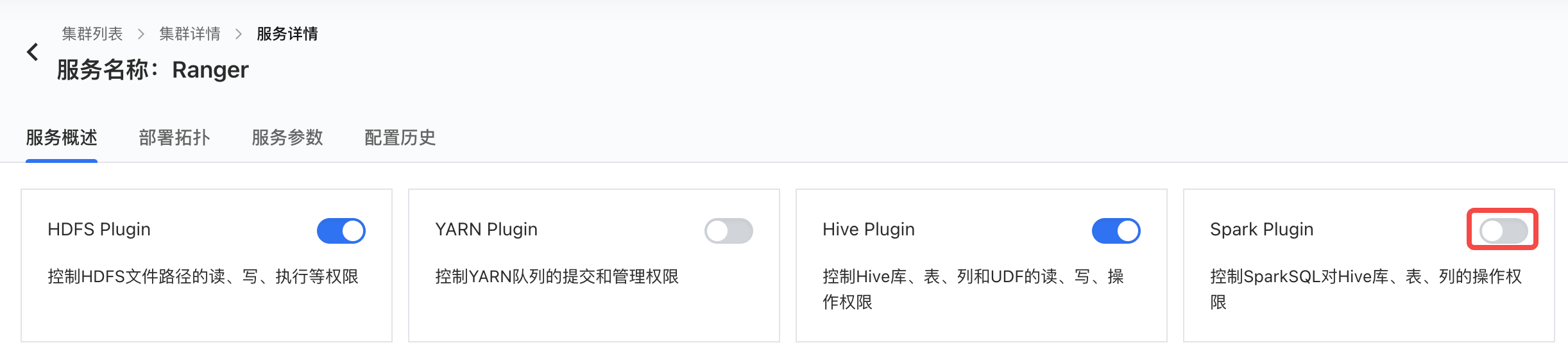

2 启用 Ranger Spark Plugin

注意

当前版本ranger-spark-plugin不适用于spark-submit等非交互式场景,会导致任务无法退出,如需要执行spark-submit任务,请关闭ranger-spark-plugin,如有疑问可通过 提工单 的方式,联系火山引擎技术支持人员。

- 集群详情 -> 服务列表 -> Ranger 服务详情 -> 服务概述页面,点击启用 Spark Plugin 开关。

- 按照提示重启 Spark 服务后生效。

3 Beeline 访问

Spark的使用方法详见 EMR Spark 快速开始

# spark 3.x beeline -u jdbc:hive2://emr-master-1-1:10005 -n <user> -p <password> # spark 2.x spark-beeline -u jdbc:hive2://emr-master-1-1:10016 -n <username> -p <password>

说明

不同 EMR 版本中节点的域名命名方式可能不同,所以上方“emr-master-1-1”可参考 EMR 的域名规则做相应调整。